MEDIA

国内外の生成AI最新動向をピックアップするメディア

【 新着記事 】

【 今週のアクセスランキング 】

生成AIニュース

Gemini無料版はどこまで使える?Pro版との違いを比較

生成AIニュース

初心者必見!Geminiアプリの使い方とダウンロード方法

生成AIニュース

徹底解説!Geminiは何がすごいのか?AI性能を詳細分析

生成AIニュース

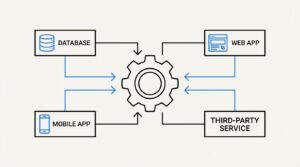

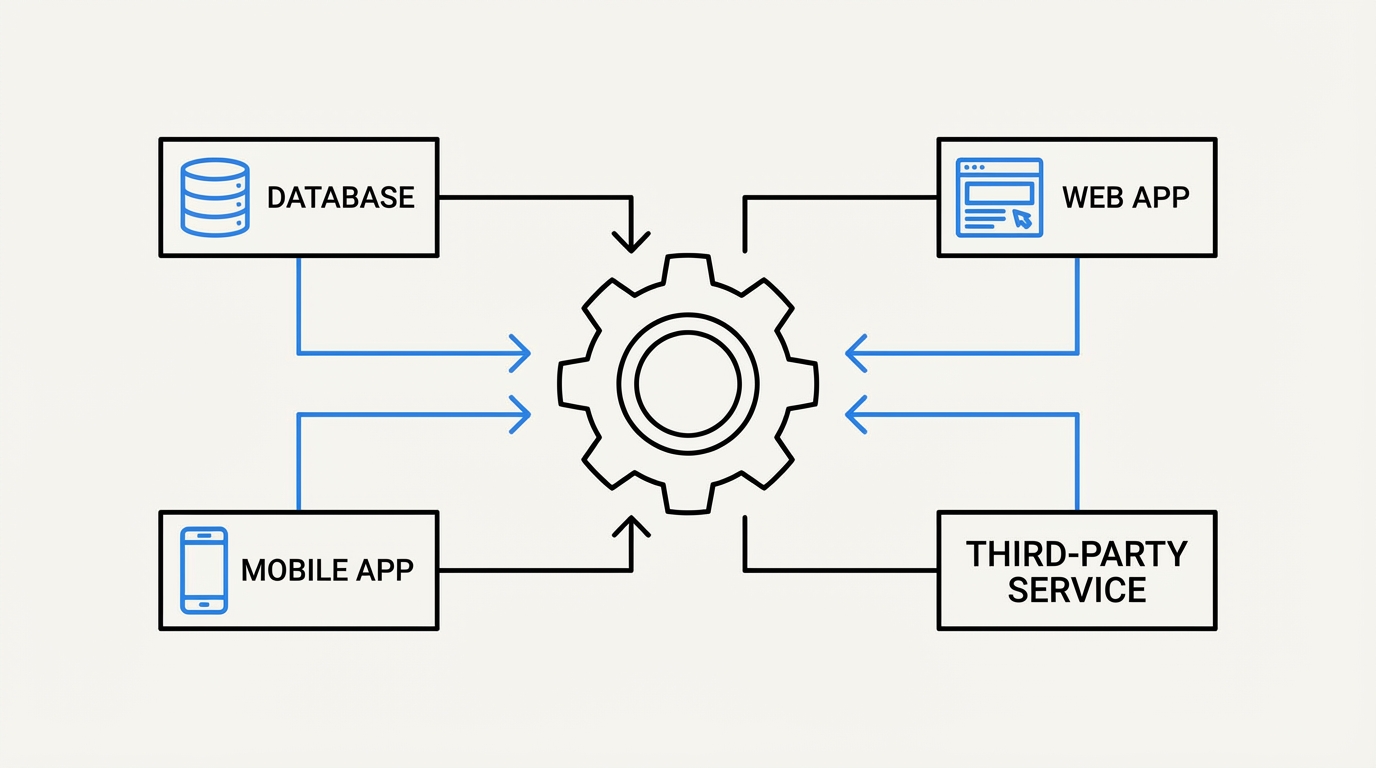

Gemini APIとは?初心者向け使い方ガイド