はじめに:ChatGPTの「メモリがいっぱいです」表示とは?

ChatGPTを利用していると、やり取りの途中で「メモリがいっぱいです」という表示が出ることがあります。この表示は、ChatGPTのメモリ機能に関連しており、会話や設定情報をシステムが保持できなくなる状態を示します。

このエラーが発生する要因は複数あり、ChatGPT内部の仕組みだけでなく、ユーザーの端末やブラウザ環境にも関係します。本記事では、メモリ不足の実態やエラーが起こる仕組みをわかりやすく解説し、具体的な対処方法まで段階的に説明します。

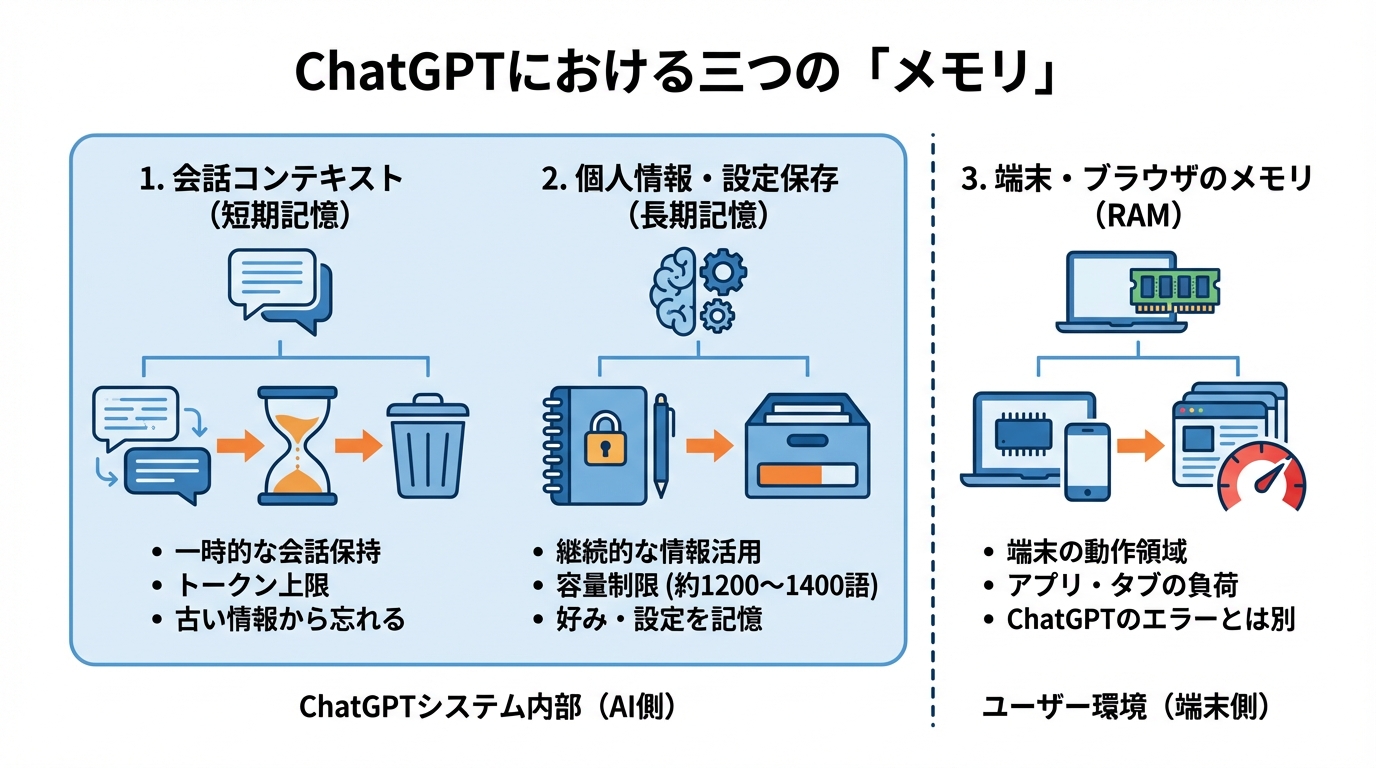

ChatGPTにおける三つの「メモリ」の意味と違い

会話コンテキストのメモリ上限

まず押さえておきたいのは、ChatGPTの「会話コンテキスト」としてのメモリです。ここでいうメモリとは、ユーザーが入力したテキストや指示を保持し、次の応答を生成するための領域を指します。大規模言語モデル(LLM)は、人間の記憶と似た仕組みで、過去のやり取りを参照して回答の精度を高めます。会話を続けるほど、以前の発言や指示を考慮した文脈保持が行われ、ユーザー体験が自然になります(参照*1)。

この会話コンテキストにはトークン上限があり、上限を超えると古い発言や情報がシステム内で切り捨てられることがあります。ChatGPTではセッション単位で会話を蓄積しますが、会話量が多くなると「メモリがいっぱいです」のようなエラーが表示されやすくなります。また、OpenAIが導入した新しいメモリ機能も、継続的にユーザー情報を活用する仕組みですが、容量には明確な上限があるため、長い対話を続けると記録しきれなくなる場合があります(参照*2)。ユーザーが直前までの会話が継続していると思っても、実際にはメモリが飽和して情報が失われることがある点が、ストレスの原因となります。

メモリ機能による個人情報の保存領域

次に重要なのが、個人情報や好みなどを保存するメモリ領域です。ChatGPTの新しいメモリ機能では、ユーザーの好みや初期設定を記録し、毎回自己紹介を繰り返さずに済むようになりました(参照*3)。たとえば「箇条書きで回答してほしい」「自分はデジタルマーケターである」といった情報を覚えておくことで、継続的かつ個別化された応答が可能です。

このメモリ機能には約1200~1400語程度の保存容量が設定されており、それを超えると新しい情報を追加できなくなります(参照*3)。Plusプラン利用者の中には、メモリがいっぱいでも警告が表示されず、新しい情報が保存されていないことに後から気づくケースも報告されています。過去の会話履歴が変わらないように見えても、実際にはメモリ容量を超えていることで情報が保存されない問題が生じます(参照*4)。

端末・ブラウザ側メモリとの違い

パソコンやスマートフォンのメモリ(RAM)容量と、ChatGPTが指すメモリは異なる点にも注意が必要です。ユーザーの端末が原因で「メモリ不足」が起こる場合は、複数のソフトや大量のブラウザタブを開いている状況が多いですが、ChatGPTの「メモリがいっぱいです」は、AIシステム内部の会話履歴や設定情報の格納上限を指します(参照*4)。

端末側のRAM不足によるアプリの強制終了とは異なるため、PCのメモリを解放してもChatGPTのエラーが改善しない場合があります。たとえばMacでBuhoCleanerという軽量化ソフトを使ってRAMを解放しても、ChatGPT内部の会話記憶には影響しません。両者を明確に区別して対処することが重要です。

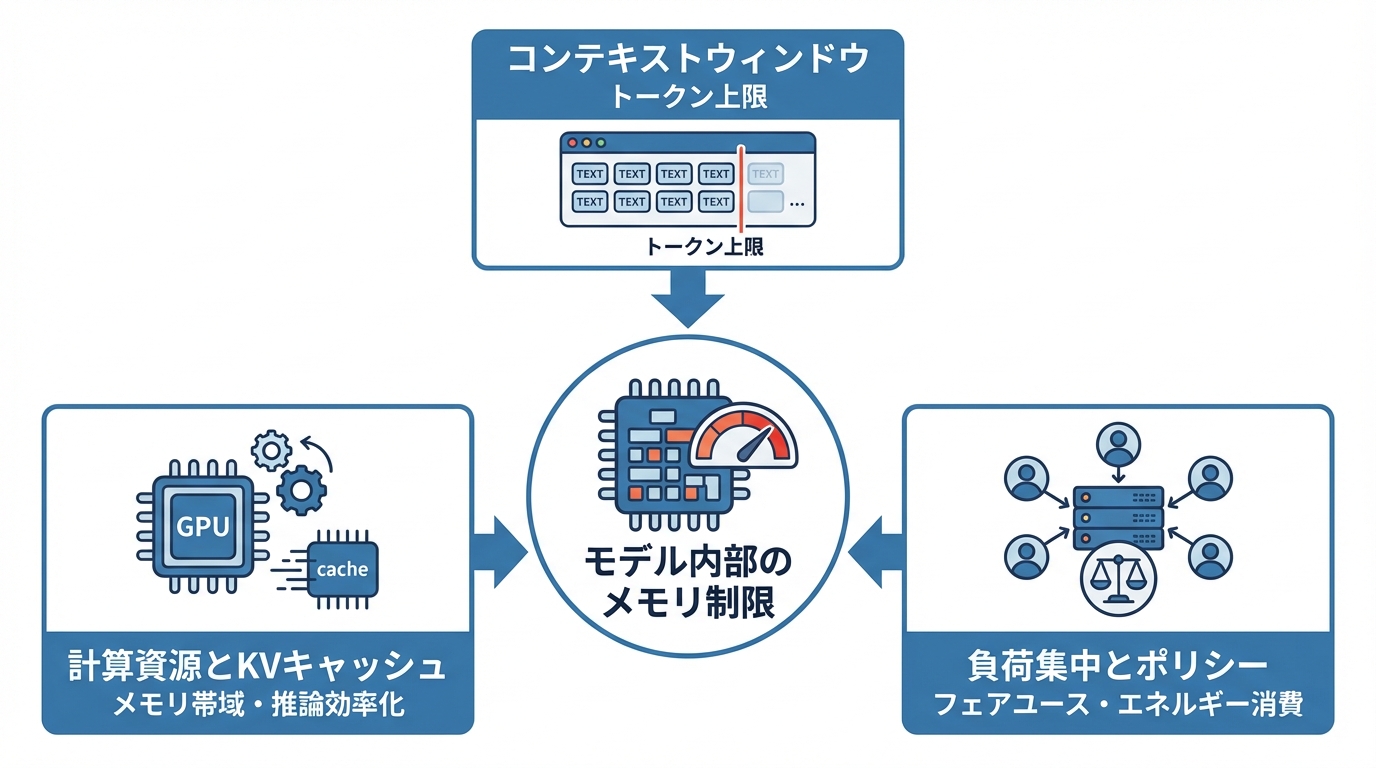

モデル内部のメモリ制限:コンテキストウィンドウと計算資源

トークン上限とトランスフォーマーの仕組み

ChatGPTなどの大規模言語モデルは、ソースコードや文章を細分化したトークンを処理単位として扱います。トランスフォーマー構造では、入力テキストをベクトル表現に変換し、自己注意機構を適用して文脈を解析します(参照*5)。このとき「コンテキストウィンドウ」と呼ばれる一度に扱えるトークン数の上限があり、これがChatGPTの会話記憶の最大範囲を決めます。

ChatGPTでは、セッションごとのメモリが約8000トークンほどに設定されており、これを超えると古いメッセージが優先度に応じて切り捨てられます(参照*4)。トランスフォーマーの計算量はトークンの長さに対して二乗で増大しますが、近年はKVキャッシュやFlashAttentionなどの技術で計算の負荷を抑える工夫も進んでいます。こうしたモデル内部の仕組みにより、一定量を超えると「メモリがいっぱいです」と表示される背景が理解できます。

KVキャッシュとメモリ帯域のボトルネック

推論を効率化するために、KVキャッシュという仕組みが利用されています。これは一度計算した自己注意のキーとバリューをキャッシュし、再計算を避けて高速化を実現します(参照*5)。大規模なモデルほど計算に時間とメモリ帯域を要するため、キャッシュの活用が重要です。

韓国KAIST計算機科学科の朴鐘世教授らはHyperAccel Inc.と共同で、GPUではなく専用のNPUコアを用いることで推論性能を平均60%以上向上し、消費電力を約44%削減できる技術を開発しています(参照*6)。このような計算基盤の進化は、モデルのメモリ管理にも影響を与えています。

負荷集中時の制限とフェアユースポリシー

大規模モデルの運用では、計算資源やエネルギー消費も大きく、負荷が集中する時間帯には一時的にメモリ制限が厳しくなる場合があります。コーネル工科大学のTianyi Chen准教授らの研究によれば、ChatGPT-4級のモデルに最大長のクエリを送ると、米国の一世帯が1分間に消費する電力量の約2倍に達する可能性があるとされています(参照*7)。

こうしたリソース消費を踏まえ、サーバーサイドではフェアユースポリシーが適用され、多数のユーザーによる同時利用を円滑にするための負荷調整が行われます。長いプロンプトや連続した処理要求を送ると、メモリ領域と計算リソースが早く限界に達し、「メモリがいっぱいです」エラーが発生しやすくなります。今後はアナログ・インメモリ計算(AIMC)などの技術でエネルギー消費の大幅削減が期待されていますが、現状では利用者側の負荷コントロールも重要です。

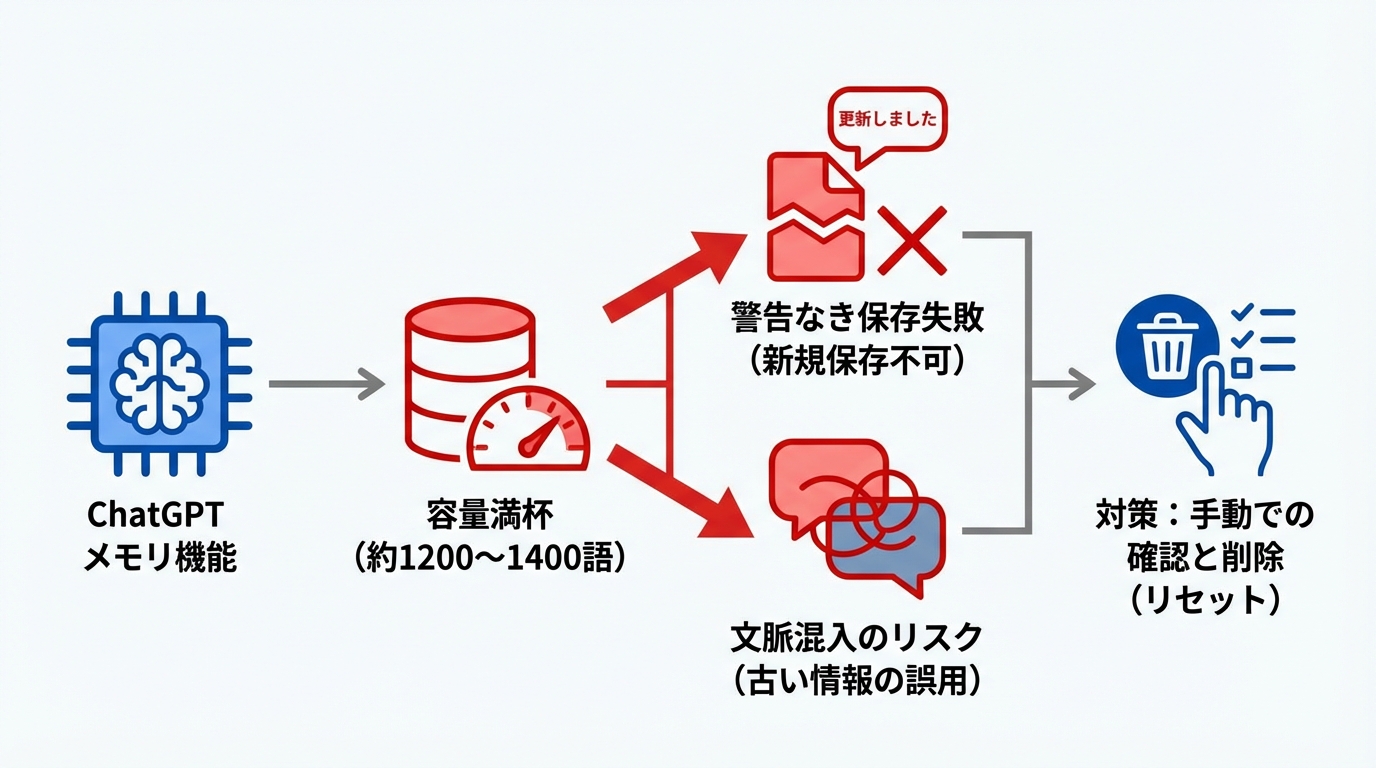

ChatGPTメモリ機能がいっぱいになったときの挙動と不具合事例

メモリエントリ容量と保存仕様

ChatGPTでメモリ機能が使われている場合、ユーザーの基本情報や好みがエントリとして保存されますが、保存容量には上限があります。プラスプランや有料プランでも大幅な拡張はできず、メモリは合計で約1200~1400語程度を保存できる仕組みです。これを超えると既存情報を削除しない限り、新たな記録が行われません(参照*3)。

また、会話を削除しても自動的にメモリがクリアされるわけではありません。設定パネルなどから手動で削除しないと、エントリが満杯のまま残る場合があるため、定期的なメモリ使用量の確認と不要な情報の整理が必要です。

メモリ満杯時の警告欠如と保存失敗事例

メモリが満杯でも警告表示がなく、保存が行われていない事例がChatGPT Plusプランのユーザーから報告されています(参照*8)。ユーザーが新しい情報を入力した際、「記憶を更新しました」と表示されても、実際には古いメモリと置き換わらず、新規情報が失われることがあります。

この現象の原因の一つは、メモリ使用量に関する表示や警告が最新版のUIで省略されていることです。以前はメモリが上限に近づくと削除か継続かを選べましたが、現在は手動でメモリエントリ一覧を確認しないと満杯かどうか分かりにくく、保存失敗に気づきにくい状況です。

メモリ機能と文脈混入のリスク

メモリ機能が満杯に近い状態で情報の更新がうまくいかない場合、古い設定情報や文脈が誤って混入するリスクが高まります。GPT-4.5(GPT-4-turbo)など特定バージョンのモデルで、保存されるはずのメモリが反映されず、別の会話文脈が優先される不具合が報告されています。2025年5月時点で最も高性能とされるGPT-4oを選択すると、メモリ機能の安定度が高まるとの見解もあります(参照*9)。

2025年4月10日から提供が始まった新しい記憶機能は、無料プランユーザーにも2025年6月3日から順次公開されていますが、開発初期段階のため不具合や仕様変更が頻繁に発生しています。文脈混入は作業や研究用途での信頼性を損なう恐れがあるため、エントリのこまめな確認と状況に応じたリセットが推奨されます(参照*10)。

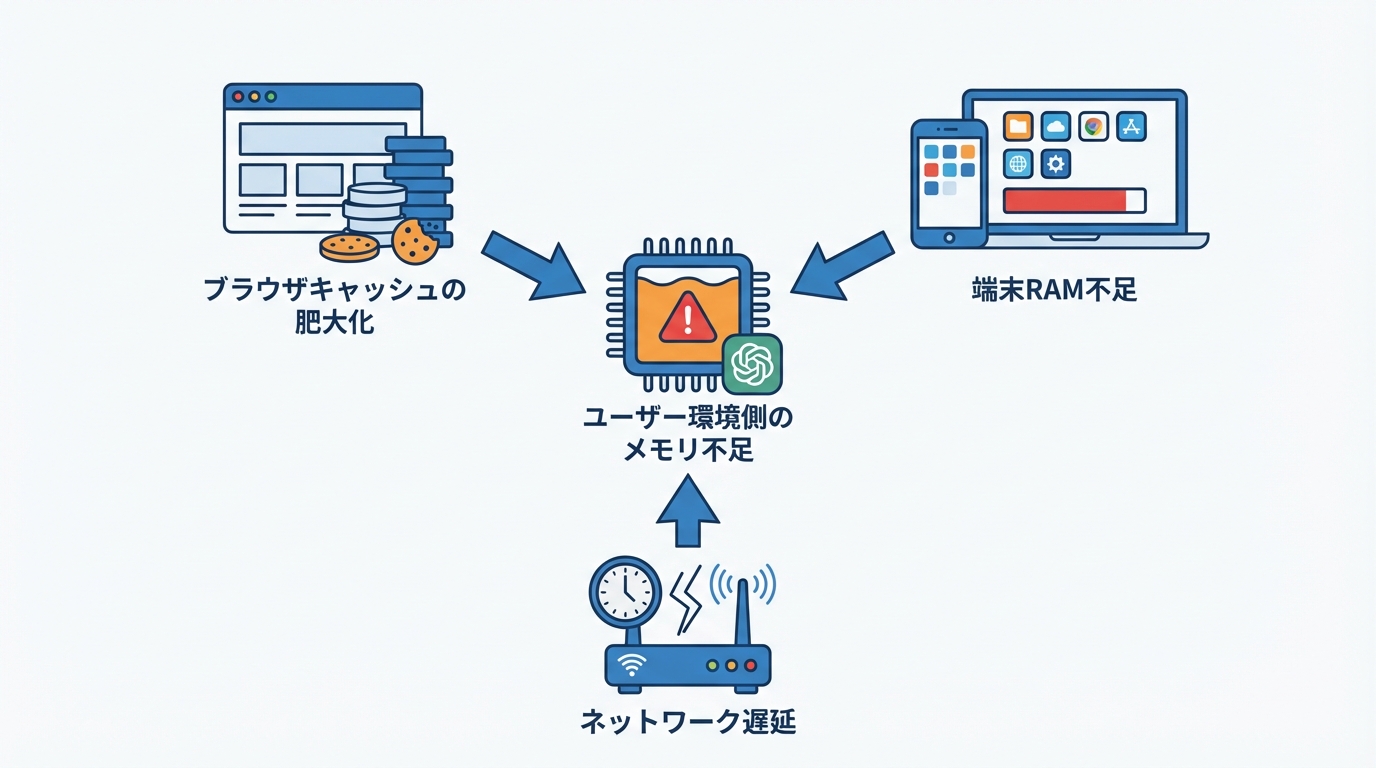

ユーザー環境側のメモリ不足:ブラウザ・端末・ネットワーク要因

ブラウザキャッシュとサイトデータの肥大化

ブラウザのキャッシュデータやCookieが肥大化すると、サイトの読み込み速度が遅くなり、ChatGPTとの通信も遅延しやすくなります(参照*11)。特にFirefoxのようなブラウザでは、Webコンテンツキャッシュやオフラインデータの保存容量が増大しやすく、ディスクスペースを圧迫してパフォーマンスが低下することがあります。ブラウザのキャッシュ管理を適宜行うことで、動作の安定を図ることができます(参照*12)。

こうしたブラウザ側の問題はChatGPTの内部メモリとは別ですが、エラーが出るきっかけになりやすいです。ブラウザからサーバーへのリクエスト時に遅延や通信エラーが発生すると、ChatGPTのキャッシュやコンテキストの同期が崩れるリスクがあります。

PC・スマホのRAM不足とアプリ不具合

ユーザー端末のRAM不足も、全体的な処理を重くしてChatGPTの動作に悪影響を与えることがあります。デスクトップ版やモバイルアプリ版のChatGPTを利用する際、他の大型アプリやブラウザタブが多数開いていると、優先度の低いプロセスがメモリを圧迫し、遅延が生じやすくなります(参照*13)。

こうした状況を避けるには、不要なアプリケーションの終了や、スマホの場合はバックグラウンド処理の見直しが有効です。MacOSユーザーでRAMを効率的に解放するには、BuhoCleanerのようなツールも活用できます。それでも解決しない場合は、ChatGPT内部の会話メモリの使いすぎが疑われるため、端末とChatGPTのメモリを個別に管理することが重要です(参照*4)。

ネットワーク遅延とサーバー側要因の切り分け

ChatGPTのレスポンスが遅れたり、応答が途中で止まったりする場合、通信環境とサーバー側の混雑や高負荷の両方を考慮する必要があります。特に利用者が多い時間帯にはサーバーへのアクセスが集中し、処理待ち時間が増加します。ユーザーが短時間に多数のリクエストを送信したり、複雑なプロンプトを投入したりすると、メモリ制限エラーが出やすくなることもあります(参照*11)。

サーバー側要因を切り分けるには、OpenAIのステータスページやSNSで同様の報告がないか確認するのが有効です。サーバー混雑時は時間帯をずらすか、GPT-3.5ベースの軽量モデルへ切り替えると負荷を軽減できます。ネットワーク接続を変えても症状が変わらない場合は、ChatGPT内部の会話メモリ整理も検討しましょう。

「メモリがいっぱいです」表示が出たときの具体的な対処ステップ

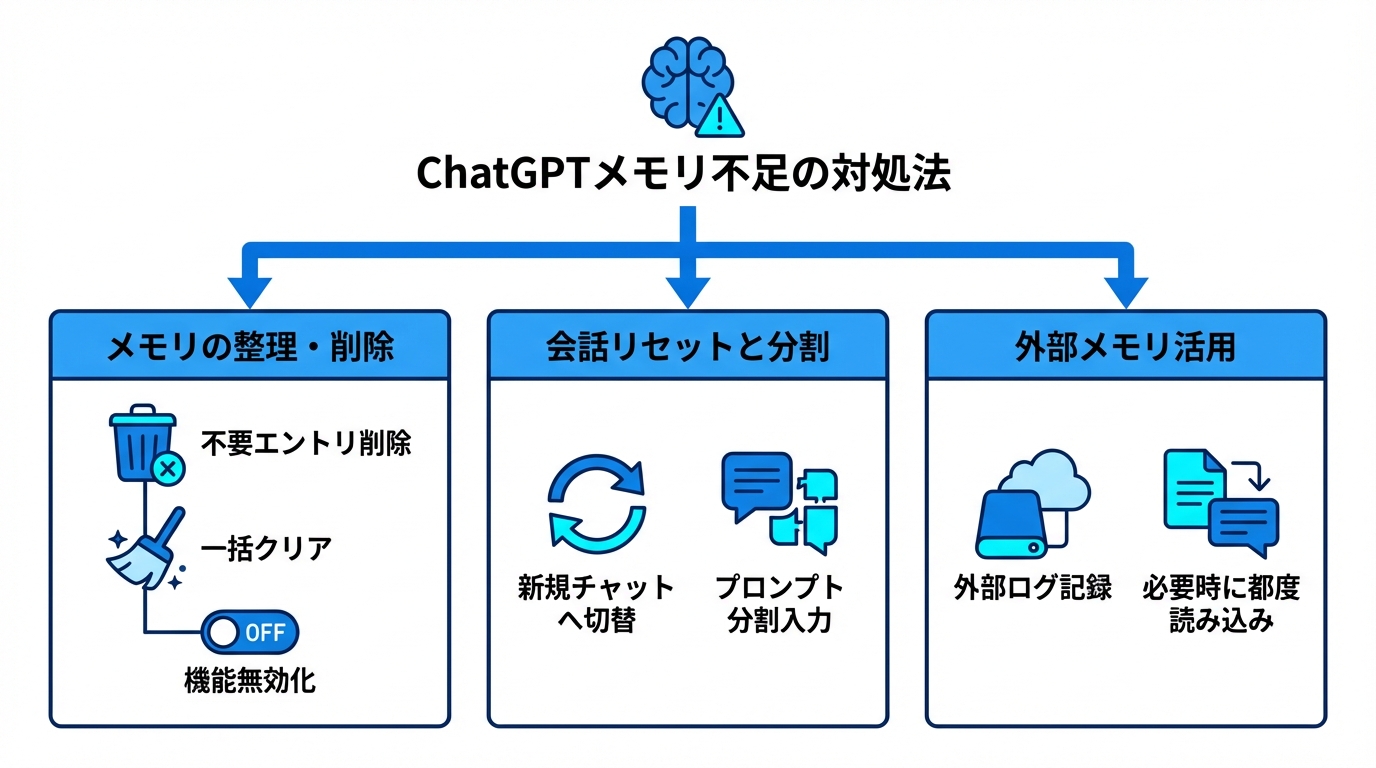

ChatGPTメモリ機能の整理・削除と無効化

メモリ機能が原因でエラーが起きている場合は、まずメモリの整理や不要なエントリの削除を検討しましょう。設定メニューの「個人化」「メモリ管理」画面から、記録されているエントリを一覧できます。不要な情報を選んで削除するか、一括クリアを利用してメモリを初期化すると、再度記憶機能が正常に動作するケースが多いです(参照*4)。

プライバシー上の理由でメモリ機能を常にONにしたくない場合は、設定から機能を無効化することも可能です(参照*14)。ただし、無効化すると過去の情報を活用できなくなるため、利便性とのバランスを考えて使い分けましょう。

会話リセットとプロンプト分割による負荷軽減

メモリが過度に膨らんでいると感じた場合は、会話をリセットするのも有効です。長文のやり取りや複数の話題を同じセッションで続けていると、内部的に蓄積されるコンテキストが多くなります。新しいチャットに切り替え、必要な情報だけを改めて入力し直すことで、余計な履歴を引き継がずスムーズに会話を続けられます(参照*11)。

また、複雑な内容を一度に詰め込みすぎると計算負荷が高まり、ユーザーにとっても管理が大変です。入力をいくつかの要素に分割し、段階的に指示することで、メモリを節約しながらやり取りの透明性を高めることができます。

外部メモリ・ログ活用による長期プロジェクト運用

セッション単位のメモリに頼りすぎると、容量不足やエラーが起きやすくなります。そこで、外部メモリを利用して必要な情報を都度ChatGPTに与える方法が有効です。具体的には、JSON形式や独自のメモリファイルに過去の対話履歴や重要なデータを記録し、必要な時に再掲することで文脈を継続できます(参照*15)。

長期プロジェクトでは、情報を外部ログに残しておき、必要な時に呼び出す形にすると安定しやすくなります。ノート管理ツールと併用して概念をまとめるなど、方法はさまざまです。ChatGPTの内部メモリだけに依存せず、外部メモリと連携して効率よく運用することがトラブル回避のポイントです。

エラーを防ぐためのメモリ設計と賢い活用のコツ

記憶させる情報の選定と要約の工夫

ChatGPTに何でも覚えさせるのではなく、保存する情報を取捨選択することが安定運用の近道です。職業や趣味などの中心的な情報や、回答形式の好みなどは優先度が高いですが、都度使い捨てにできる小さなメモは必要に応じて入力すれば十分です。短い対話の中で過度に詳細な情報を与えると、メモリの使用量が増えてエラーを誘発しやすくなります(参照*3)。

不要な冗長表現を避け、定期的に会話内容を要約しながら進めるとメモリ消費を抑えられます。ユーザーから「ここまでの経緯を短くまとめて」と依頼し、自動生成された要約を次のステップごとに整理するのも有効です。

プロジェクト単位のメモリ運用とMaster Memory

複数のテーマや案件を同じセッションで扱うと、メモリの混在で文脈が混乱しやすくなります。プロジェクト単位で会話を分ける運用が有効です。過去の履歴を8カテゴリ程度に区分して記録する「Master Memory」という手法もあり、会話の分類と要約を定期的に行い、.csvファイルなどで参照できるようにする仕組みです(参照*16)。

プロジェクトごとに決まったカテゴリー(アイデンティティ、課題、成果など)に沿ってまとめ、会話が長くなりそうな場合は途中でマスターファイルに要約を追記します。外部ファイルとして管理しておけば、モデルの内部メモリが一杯になっても、過去情報を読み込み直せる利点があります。

メモリ機能を使わない運用とプライバシー対策

メモリ機能は便利ですが、プライバシーや情報管理の観点から常に使うべきとは限りません。機密情報やパスワード、クライアントの極秘データなどは、チャットのメモリに残さず、外部の安全なシステムに保管するのが基本です(参照*2)。一度記憶させてしまうと、誤って別の文脈で参照されるリスクもあります。

設定パネルから「メモリ無効化」を選ぶことで、ChatGPTがユーザー情報を蓄積しない形で利用できます(参照*10)。プライベートな情報漏洩が心配な場合は、必要な内容だけその都度指示する運用も選択肢です。

おわりに:メモリエラーと上手に付き合うために

「メモリがいっぱいです」という表示は、ChatGPTがユーザーの情報をより良く活用しようと進化した結果生じる側面もあります。正しい理解と運用の工夫で、より便利な体験が得られます。

混雑や端末の問題、ChatGPT内部のコンテキスト上限などを切り分けながら、必要に応じて対策を重ねていきましょう。日常的にメモリをメンテナンスし、プロジェクトごとに会話を分割することで、長期的な対話体験を快適に維持できます。

監修者

安達裕哉(あだち ゆうや)

デロイト トーマツ コンサルティングにて品質マネジメント、人事などの分野でコンサルティングに従事しその後、監査法人トーマツの中小企業向けコンサルティング部門の立ち上げに参画。大阪支社長、東京支社長を歴任したのち2013年5月にwebマーケティング、コンテンツ制作を行う「ティネクト株式会社」を設立。ビジネスメディア「Books&Apps」を運営。

2023年7月に生成AIコンサルティング、およびAIメディア運営を行う「ワークワンダース株式会社」を設立。ICJ2号ファンドによる調達を実施(1.3億円)。

著書「頭のいい人が話す前に考えていること」 が、82万部(2025年3月時点)を売り上げる。

(“2023年・2024年上半期に日本で一番売れたビジネス書”(トーハン調べ/日販調べ))

参照

- (*1) From Human Memory to AI Memory: A Survey on Memory Mechanisms in the Era of LLMs

- (*2) OpenAI Launches New ChatGPT Memory Feature

- (*3) Master ChatGPT memory in 2025

- (*4) Dr.Buho – ChatGPT Memory Full? Here's the Proven Fix

- (*5) Transformer (deep learning)

- (*6) EurekAlert! – Development of core NPU technology to improve chatGPT inference performance by over 60%

- (*7) Cornell Chronicle – Researchers tackle AI’s energy problem with a greener fix

- (*8) OpenAI Developer Community – ChatGPT Plus Plan Memory Issue: No Warning When Memory is Full, Leading to Lost Entries

- (*9) OpenAI Developer Community – ChatGPT Memory Will Not Save!

- (*10) Simon Willison’s Weblog – I really don’t like ChatGPT’s new memory dossier

- (*11) 初心者のための生成AI活用ブログ – ChatGPTが重い・遅いときの原因と解決策を徹底解説|すぐ試せるチェックリスト付き

- (*12) Excessive usage of disk space by Firefox

- (*13) note(ノート) – ChatGPTの返答が遅いときの原因と対処法【2025年版】|東京 AI 研究所

- (*14) EZ DESIGN TIPS – 【コピペOKの最強プロンプト】ChatGPT副業で稼ぐ!ライティングに使えるプロンプトとコツ

- (*15) OpenAI Developer Community – Building Your External Memory System: When User Memory is Full or Nonexistent

- (*16) OpenAI Developer Community – Memory full error workaround