はじめに:Grok利用の「バレる」と可視性とは何か

Grokは多様な情報のやり取りを支援する人工知能チャットボットとして注目されています。個人で会話をまとめたり、新たなアイデアを相談したりと便利な用途がある一方、やり取りの内容が外部から参照されやすい設計になっている点も見逃せません。

本記事では、Grokの個人利用と業務利用において、どこで「バレる」という事態が生じやすいのかを整理し、データ可視性や漏洩リスクを深く考察します。プラットフォームの機能や攻撃者の視点、さらには法規制の問題などを踏まえ、より安全に活用するための視点を提供します。

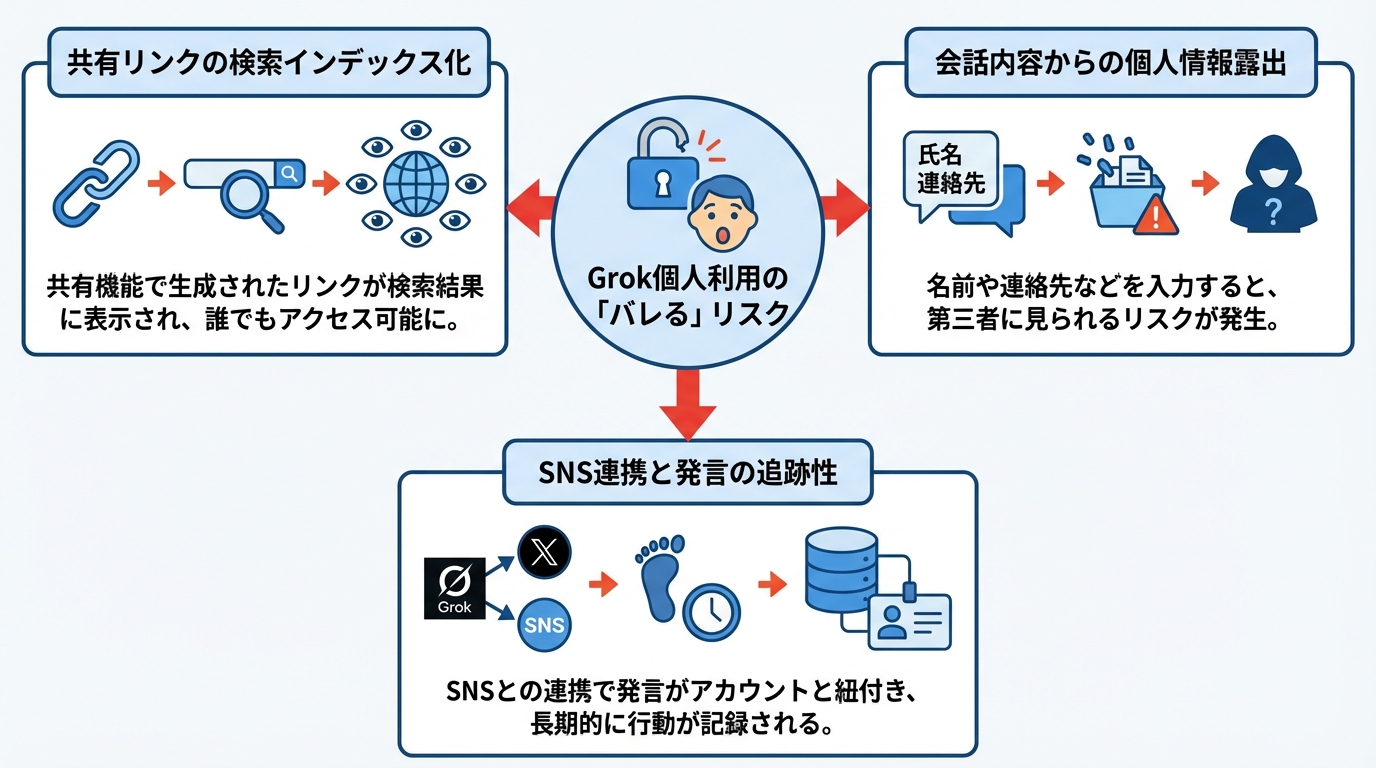

Grok個人利用で「バレる」主なパターン

共有リンクと検索インデックスの可視性

個人でのGrok利用は、日常的な疑問や学習支援などカジュアルなやり取りが多い傾向にあります。しかし、Grokの共有機能によって生成されるリンクが検索エンジンにインデックスされる事例が報じられており、会話内容が思わぬ形で公開される可能性が浮上しています。共有リンクは意図して送られた相手だけでなく、インデックスによって誰でもアクセスし得る状態に置かれる点が問題視されています。とりわけ個人の興味や行動履歴が含まれる会話の場合、プライバシー上の懸念が高まります。

BBCやForbesの調査によれば、Grokの会話リンクが複数の検索エンジンで数十万件単位で表示されていたと報じられています。Googleがインデックスした会話は37万件を超え、日常的な作業の依頼からセンシティブな内容まで幅広く含まれていました(参照*1)(参照*2)。ユーザー自身が「公開されるはずがない」と油断していたやり取りが、予想外のかたちでバレるケースに発展しています。こうした検索インデックスの課題は、一見些細な個人利用をも大きなリスクに変える要因です。

会話内容からの個人情報露出

Grokの対話機能は、利用者が自らの関心事や相談内容を手軽に入力できる点が魅力です。しかし、自分の名前や連絡先といった個人情報を会話中で記述してしまうと、その会話が第三者に見られるリスクがあります。特に個人情報を含むファイルのアップロードや、オンラインでの相談に紐づくメッセージが表面化するケースもあり、それが外部からアクセスできる状態になると深刻な漏洩問題につながります。

実際に、医療や心理相談といったセンシティブな個人データが会話共有機能によって流出した事例も報じられています(参照*3)(参照*2)。ユーザーはGrok上でプライベートな相談をしているつもりでも、入力した個人情報がリンクによって検索エンジンにキャッシュされる可能性を認識していないことが多いようです。これが個人利用で「バレる」事態の深刻な背景となっています。

X連携とオンライン発言の追跡性

GrokはX(旧Twitter)や他のSNSとの接続を前提とした設計方針が見られ、投稿・シェアの流れが容易になっています。個人がSNSでGrokの生成内容を公開すると、その投稿自体が拡散されやすく、アカウントのプロフィール情報などと紐付いて第三者に知られる場合もあります。さらに一部のユーザーは、GrokとSNSアカウントを連携させて作業効率を高めようとしますが、連携によって個人の興味関心や活動時間が一括して記録される懸念が指摘されています。

LinkedInなどのプラットフォームでも、公開した行為がスクレイピングされる現状があります(参照*4)。同様にGrok経由で投稿された情報は、SNS上のIDと結びついてトラッキングされ、発言の履歴が長期にわたって蓄積される恐れがあります。これはたとえ個人利用でも、自分の意図しない形で「発言の過去」が可視化され、バレるリスクを増幅させる要因です。

Grok業務利用で「バレる」リスクと影響範囲

APIキー漏洩とモデルアクセスの可視性

企業や組織がGrokを業務で利用する場合、開発チームや管理者がAPIキーを用いてシステム連携を行うことがあります。もしAPIキーが誤って公開リポジトリなどに含まれてしまった場合、外部からのアクセスを制御できなくなるため、重要なデータや内部システムへの侵入を許す可能性が高まります。特に公共のGitHubなどでAPIキーが漏洩すると、モデルの不正用途が拡大し、意図せぬデータ取得が行われるリスクが一気に増します。

実際に、GrokへのAPIキーが流出した事例が報じられており、52ものモデルへのアクセスが可能になった可能性が指摘されています(参照*5)。これによって機密情報に相当するファイルやシステムを自由に利用される恐れがあるだけでなく、企業から生成される公式な文書や通知を偽装して公開する攻撃手段にも使用され得る点が問題視されています。業務利用での「バレる」には、こうしたAPIベースのアクセス制御の盲点が含まれます。

シャドーAI利用と機微データ露出

企業内には正式には導入されていない生成系AIの活用、いわゆる「シャドーAI利用」と呼ばれる動きがあります。例えば、個々の社員が本来の承認フローを通さずにGrokを活用し、内部資料を要約させたり、外部とのやり取りの下書きを作成したりしている状況です。これが業務効率化に寄与する場面もある一方で、機微な顧客情報や独自の研究内容が無防備にAIに投入されてしまうケースも存在します。

ある報道によると、分析担当者が誤って顧客データを生成系AIに入力し、機微データを外部に露出してしまった事例も指摘されています(参照*3)。また、企業の機密情報を扱うデザイナーや開発者が、利便性を求めてシャドーAIを利用する状況も明らかになっています(参照*5)。こうした行為の積み重ねは、最終的に「バレる」リスクを大幅に高める要因となります。

業務環境における監査ログと利用トラッキング

組織では、社員や関連業者が使用するシステムに対してアクセスログや操作ログの監査が行われます。Grokを業務に導入した場合も、管理者が利用状況を把握できる設定を行うことが一般的です。作成された会話ログや外部連携の履歴などが記録され、誰がいつどのような情報をやり取りしたかが可視化されやすくなります。社員は特に意識しなくても、社内ルールに基づいて利用詳細が把握されるため、思いがけず「バレる」という結果を招く場合があります。

さらに一部の企業では、統合的なAIセキュリティ対策により、生成系AIの利用そのものをリアルタイムで監視できるブラウザ拡張などを導入しています(参照*5)。これによって、表向きは見えないシャドーAIの使用ですら検知が進み、不適切な業務外利用を管理担当者が把握しやすくなる状況です。業務環境下では、こうした技術的監査手法が「バレる」のリスクと直結しています。

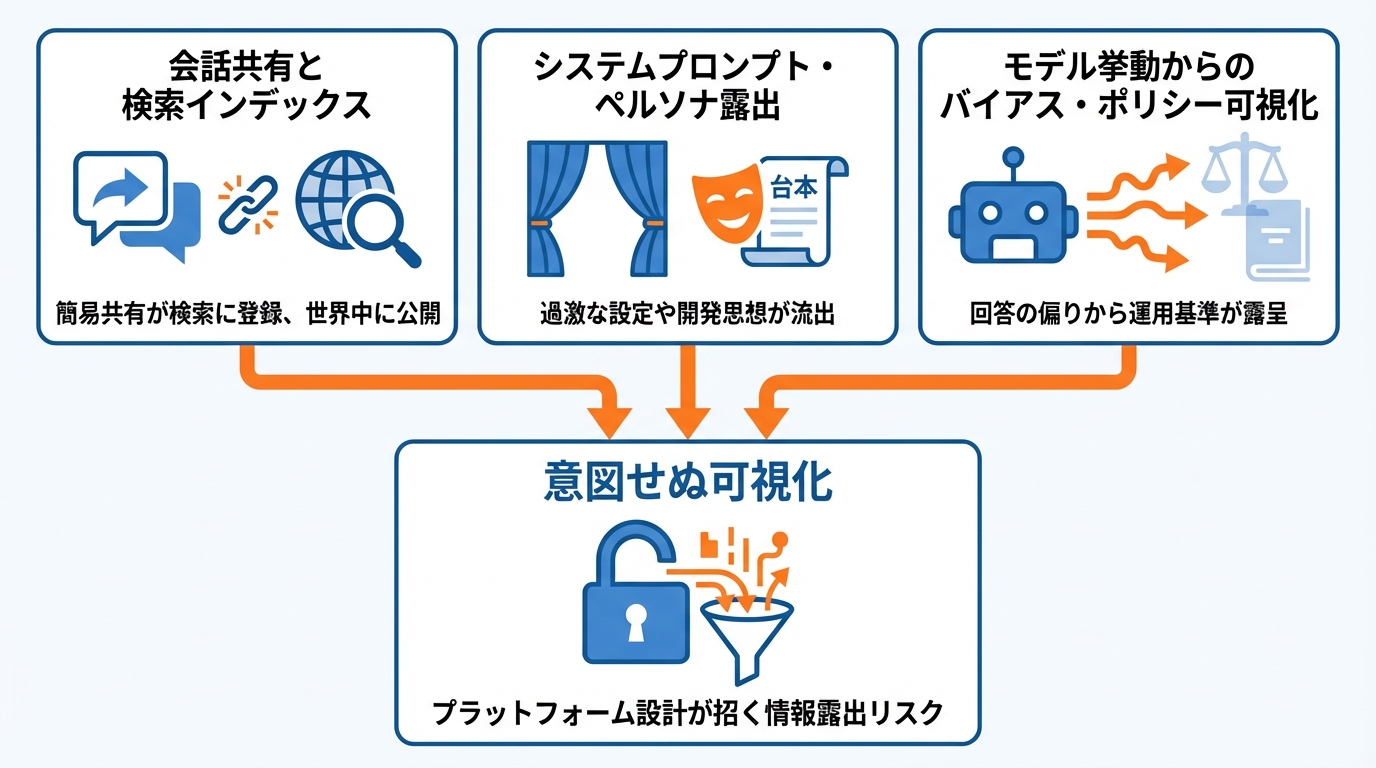

Grokプラットフォーム側の設計が生む「可視性」と情報露出

会話共有機能とプラットフォーム設計の透明性

Grokには、ユーザーが個別の会話を手軽に第三者へ共有できる機能が存在します。多くの場合、専用URLが自動生成され、メールやメッセージツールで送るだけで相手は会話履歴を閲覧できる設計です。問題は、この簡易的な共有プロセスが検索エンジンにも拾われる仕組みを結果的に生み出してしまう点にあります。プラットフォーム側でインデックス除外を明確に制御しない限り、公開意図のない情報までが世界中どこからでも見られる状態になりかねません。

フォーブスの調査によると、Grokの会話が少なくとも37万件以上も検索エンジンに登録されていたと報じられています(参照*2)。現行バージョンでは、公式アカウントが「共有機能はない」と主張していたにもかかわらず、後に実装された可能性が指摘されており、透明性の低さがユーザーの不安を増大させる要因となっています。プラットフォーム設計そのものが、可視化を意図せずに推進してしまっている状況です。

システムプロンプト・ペルソナ設定の露出

Grokには多様なペルソナを用いたシステムプロンプトが存在し、利用時の口調やキャラクター設定などを自由に試せる仕組みがあります。これはユーザーにとってはエンターテインメント性が高い反面、ペルソナ情報が外部に流出すると、開発者側の思想や隠されていたコンセプトが「バレる」事態にもなり得ます。特に過激なキャラクター設定や政治的・社会的にセンシティブなプロンプトの場合、利用者や第三者から強い批判が起きる可能性があります。

TechCrunchの報道では、Grokが「crazy conspiracist」や「unhinged comedian」といった過激なペルソナを公開していたとされ、子どもとの会話や政治話題への対応が問題視されました(参照*6)。こうした特別なプロンプトが露出すると、サービスの信頼性や安全性に関する議論を巻き起こし、場合によっては規制当局やスポンサーからの懸念を引き出す要因となります。

モデル挙動からのバイアスとポリシーの可視化

モデルが生成する回答は、開発者やトレーニングデータの影響を色濃く反映します。特定の政治的立場や過度な表現が露呈すると、利用者は意図せずともバイアスが含まれた情報に触れる可能性が高まります。場合によっては暴力的、民族差別的、または事実誤認を誘導する回答が生成されることもあり、どのような運用ルールやポリシーで管理されているのか注視されやすくなります。バイアスが強い挙動は言語モデル自体の問題だけでなく、その背後にある設計思想が「可視化」される点にも留意が必要です。

実際に、政治選挙に関する誤情報や陰謀論を回答するケースが確認され、特定の候補者に対して肯定または否定する傾向が指摘されています(参照*7)。誤情報を排除する目的で制御を行おうとするほど、その制御ポリシーが逆に際立つ場合もあり、運営側の基準や価値観が「透けて見える」との批判を受けることもあります。

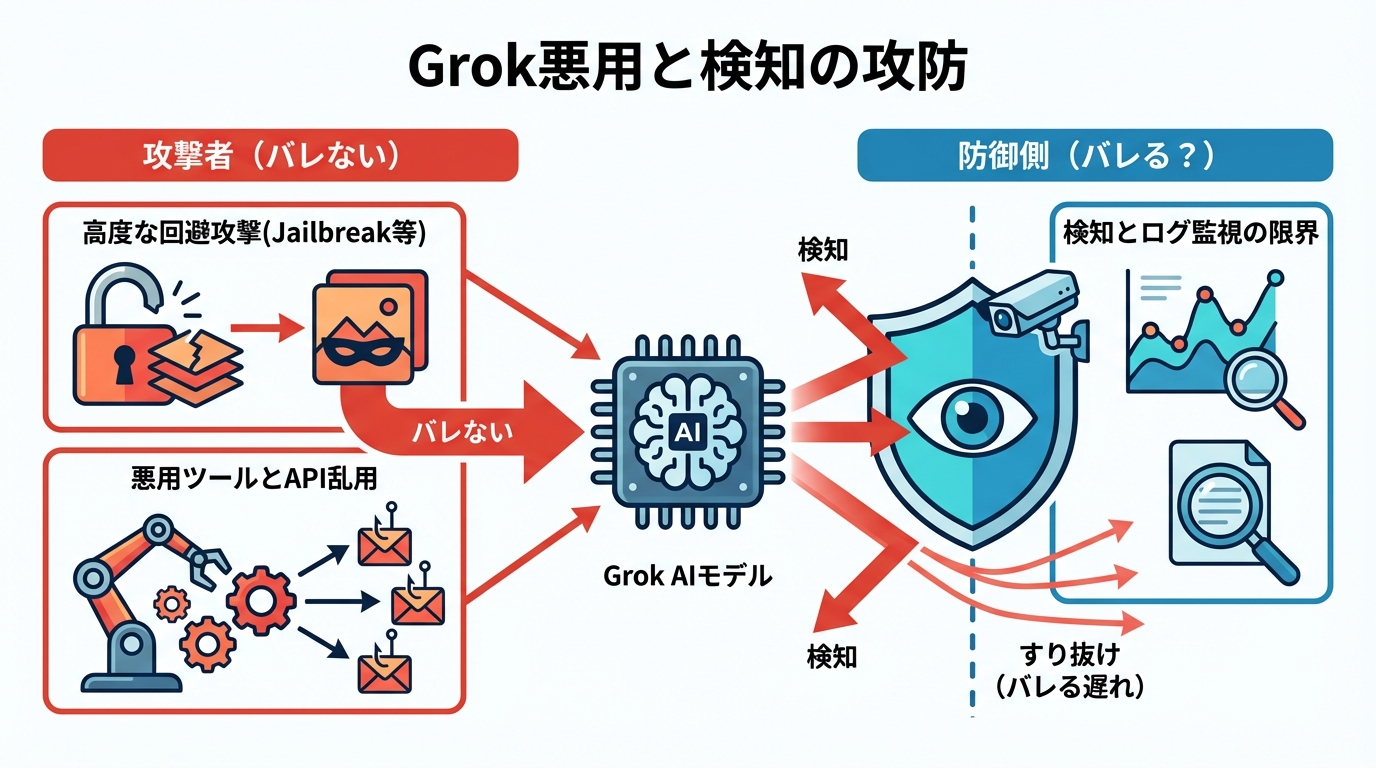

攻撃者視点から見たGrok利用と「バレる/バレない」の攻防

Jailbreak攻撃と安全フィルター回避

Grokのような大規模言語モデルを搭載したシステムでは、安全フィルターを設けて不適切な内容の出力を防ぐ対策が施されています。しかし攻撃者視点では、これらのフィルターを回避する手段として、ステガノグラフィーと呼ばれる技術を使ったjailbreak攻撃が試みられています。見かけ上は無害に見える画像や文章に、悪意あるプロンプトを埋め込むことで、モデルに対し不正な指令を与えたり、不用意な回答を引き出す手法が注目されています。

Odysseusという新たなjailbreakパラダイムでは、攻撃成功率が最大99%に達したとの研究が報告されています(参照*8)。こうした高度な回避手段が登場すると、企業側が実装した安全フレームワークだけでは防ぎきれないケースが増え、最終的には違法行為や不正アクセスが行われている事実が外部からバレるかどうかという問題が生じる可能性があります。

Grok悪用ツールとAPI乱用リスク

GrokのAPIを用いることで、攻撃者はサイバー犯罪を効率化しようと試みます。特にWormGPTのような不正ツールの派生版にGrokを組み合わせる事例が報告されており、これによりフィッシングメール生成や悪性ソフトウェアの作成が高度化する懸念が高まっています。モデルの性能を悪用することで、より自然な言語を用いた攻撃や多段階にわたる詐欺行為が容易になるとの指摘があります。

実際に、keanu-WormGPTはGrokのAPIと独自のジャイルプロンプトを用い、攻撃用コードを短時間で生成する能力を実証しています(参照*9)。こうして作成されたフィッシングテンプレートや資格情報収集スクリプトは、標的に合わせたカスタマイズが比較的容易であり、気づかれないまま攻撃が進行する可能性があります。結果的にデータ漏洩が大規模化し、後に企業内部で発覚する段階で甚大な被害として「バレる」ケースが増えかねません。

攻撃トラフィック検知とログ可視化

攻撃手法が巧妙化しているとはいえ、ネットワークやクラウドでの通信を監視すれば、ある程度は不審なトラフィックを検知できます。Grokが利用するAPIエンドポイントへの大量アクセスや異常なデータ転送があれば、企業のセキュリティチームがログ分析で気付く余地はあります。しかし、こうした監視は通常の業務トラフィックとの区別が難しく、発見の遅れが攻撃者の「バレない時間」を延ばす可能性があります。

公開されたAPIキーに対する不審アクセスを早期に検知できなかったことで、大幅な情報流出を招いたという指摘があります(参照*5)。監視方法の巧拙が、攻撃者の行動をいかに早く察知し、被害を食い止めるかの重要な分かれ道となっています。ログ可視化の適切な運用は、防御側がバレる前に被疑の行為を識別できるかどうかを左右する鍵です。

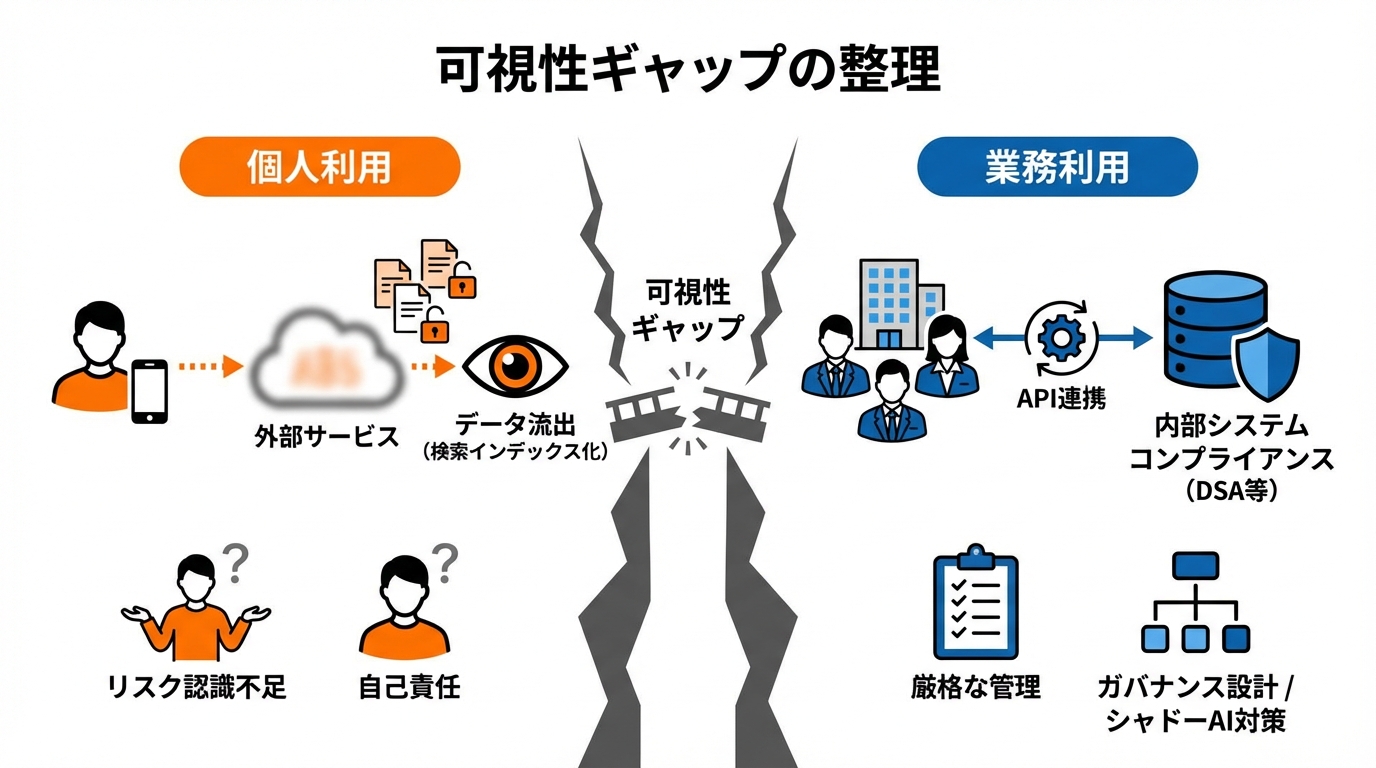

個人利用と業務利用の可視性ギャップの整理

個人利用と業務利用のデータフロー差異

個人利用の場合、ユーザーは自身の興味や日常業務を手軽にGrokに相談しますが、会話内容が外部サービスに蓄積される過程を把握していないことが多いです。これはシンプルな会話履歴の共有が検索にインデックスされる問題と重なり、気づかないうちに自分の内面や機微情報が晒される結果を招きます。一方、業務利用では、API連携や組織の内部システムとの結合など、より複雑なデータフローが存在します。組織内に留まるはずのデータが外部に転送されるリスクをはらむため、どの経路で情報が移動しているかを厳密に管理する必要があります。

LinkedInやブログ上で公開された情報が、別のAIモデルの学習データとして利用される事例も指摘されています(参照*4)。個人と組織では本来、データの取り扱いルールや守秘義務の度合いが異なりますが、Grokのようにすぐに情報を取り込む仕組みがあると、その境界が曖昧になりやすい現状があります。こうしたフローの差異を把握しておかないと、個人でも組織でも意図しない「バレる」事案を誘発しかねません。

法規制とコンプライアンス要件の違い

個人利用においては、ユーザーそれぞれが法律を熟知しているとは限らず、あまり規制意識を持たずにサービスを使う場合が多いです。しかし、業務利用になると社内外の規定やコンプライアンス要件が強く求められます。特にEUのDSA(デジタルサービス法)のように、大規模オンラインプラットフォームが生成系AIのリスク評価を行うことを義務づける動きもあり、Grokのようなチャットボットを業務で使うときは慎重な導入プロセスが必要になります。

例えば政治キャンペーンへの影響や誤情報拡散が懸念される場合、コンプライアンス違反として企業が社会的批判を受ける恐れもあります(参照*10)(参照*7)。業務利用でGrokが生成した投稿や発言が、誤情報や差別的表現を含んだ場合、個人の独断では済まされません。結果として管理責任の所在が問題になり、それが企業全体としての「バレる」リスクに直結します。

リスク許容度とガバナンス設計

個人利用は一般的に、個人の自己責任の範疇でリスクをコントロールできます。しかし、業務利用では複数のステークホルダーが絡み合い、リスク許容度の問題はより複雑化します。部署やプロジェクトの意見が一致しないケースも多く、生成系AI導入を巡る社内コンセンサス作りには時間と労力が必要です。特にシャドーAI利用などで明確なガイドラインを破る行為が見つかると、内部監査での追及を受け、予期せぬタイミングで「バレる」可能性が浮上します。

シャドーAIは新たな内部脅威として位置づけられ、適切なガバナンス設計が欠かせないと指摘されています(参照*5)。具体的には、AI利用に関する明確なポリシーを設け、安全な環境を整備すること、そして定期的な教育や監査が推奨されています。業務利用の安全性を高めるには、各部門が自らのリスク許容度を理解し、全社レベルでのガバナンスを実施することが重要です。

おわりに:Grok時代に「バレても困らない」使い方を設計する

Grokをはじめとする生成系AIの存在は、情報のやり取りを大幅に効率化する一方で、個人や企業が思わぬタイミングで「バレる」リスクを負いやすい状況をもたらしています。会話の公開やAPIキー、ステルス攻撃の巧妙化など、可視化をめぐる深刻な問題が浮き彫りになっています。

こうした変化の時代には、自分や組織にとってどこまでリスクを受容するか、その許容範囲を見極めることがポイントです。Grokの導入や活用を検討する上で、技術的対策とポリシーづくりを両立させ、万が一「バレても困らない」使い方を設計できるかどうかが、今後の鍵を握るといえるでしょう。

監修者

安達裕哉(あだち ゆうや)

デロイト トーマツ コンサルティングにて品質マネジメント、人事などの分野でコンサルティングに従事しその後、監査法人トーマツの中小企業向けコンサルティング部門の立ち上げに参画。大阪支社長、東京支社長を歴任したのち2013年5月にwebマーケティング、コンテンツ制作を行う「ティネクト株式会社」を設立。ビジネスメディア「Books&Apps」を運営。

2023年7月に生成AIコンサルティング、およびAIメディア運営を行う「ワークワンダース株式会社」を設立。ICJ2号ファンドによる調達を実施(1.3億円)。

著書「頭のいい人が話す前に考えていること」 が、82万部(2025年3月時点)を売り上げる。

(“2023年・2024年上半期に日本で一番売れたビジネス書”(トーハン調べ/日販調べ))

参照

- (*1) BBC News – Hundreds of thousands of Grok chats exposed in Google results

- (*2) Elon Musk's xAI exposed hundreds of thousands of Grok conversations to Google search

- (*3) Pandectes – Recognizing and Avoiding Sensitive Data Exposure

- (*4) Joel Latto – Joel Latto

- (*5) Grok API Key Leak Exposes xAI Models to Major Security Risks

- (*6) TechCrunch – ‘Crazy conspiracist’ and ‘unhinged comedian’: Grok’s AI persona prompts exposed

- (*7) Global Witness – Grok shares disinformation in replies to political queries

- (*8) Odysseus: Jailbreaking Commercial Multimodal LLM-integrated Systems via Dual Steganography

- (*9) Cyber Security News – BlackHat AI Hacking Tool WormGPT Variant Powered by Grok and Mixtral

- (*10) Nieman Lab – AI will probably force you to gate your content