はじめに

Kimi K2.5は、中国のMoonshot AIが公開したオープンソースのAIモデルです。テキストに加えて画像や動画も理解でき、仕事の文章作成から開発作業まで幅広く使える土台になり得ます(参照*1)。

この記事では、Kimi K2.5がどんなモデルかを押さえたうえで、仕様、性能の見方、導入手順と注意点を、むずかしい言い回しを避けて整理します。DX推進やAI導入の担当者が「PoCで止まらず、業務にのせるには何を確認すべきか」を判断しやすい形にまとめます。

Kimi K2.5とは

Moonshot AIとKimiシリーズ

Moonshot AIは中国のAI企業で、Kimiというシリーズ名でモデルやツールを展開しています。TechCrunchによると、Moonshot AIは2026年1月27日に新しいオープンソースモデルとしてKimi K2.5を公開し、テキスト・画像・ビデオを理解するマルチモーダル対応だと説明しています(参照*1)。

TechCrunchは、Moonshot AIが元Google・Meta AIの研究者である楊智林(Yang Zhilin)氏によって設立されたことや、資金調達・評価額に関する報道にも触れています(参照*1)。導入検討では、モデル単体の性能だけでなく、開発体制や提供チャネル(APIやツール)が続く見込みも合わせて見ておくと判断しやすくなります。

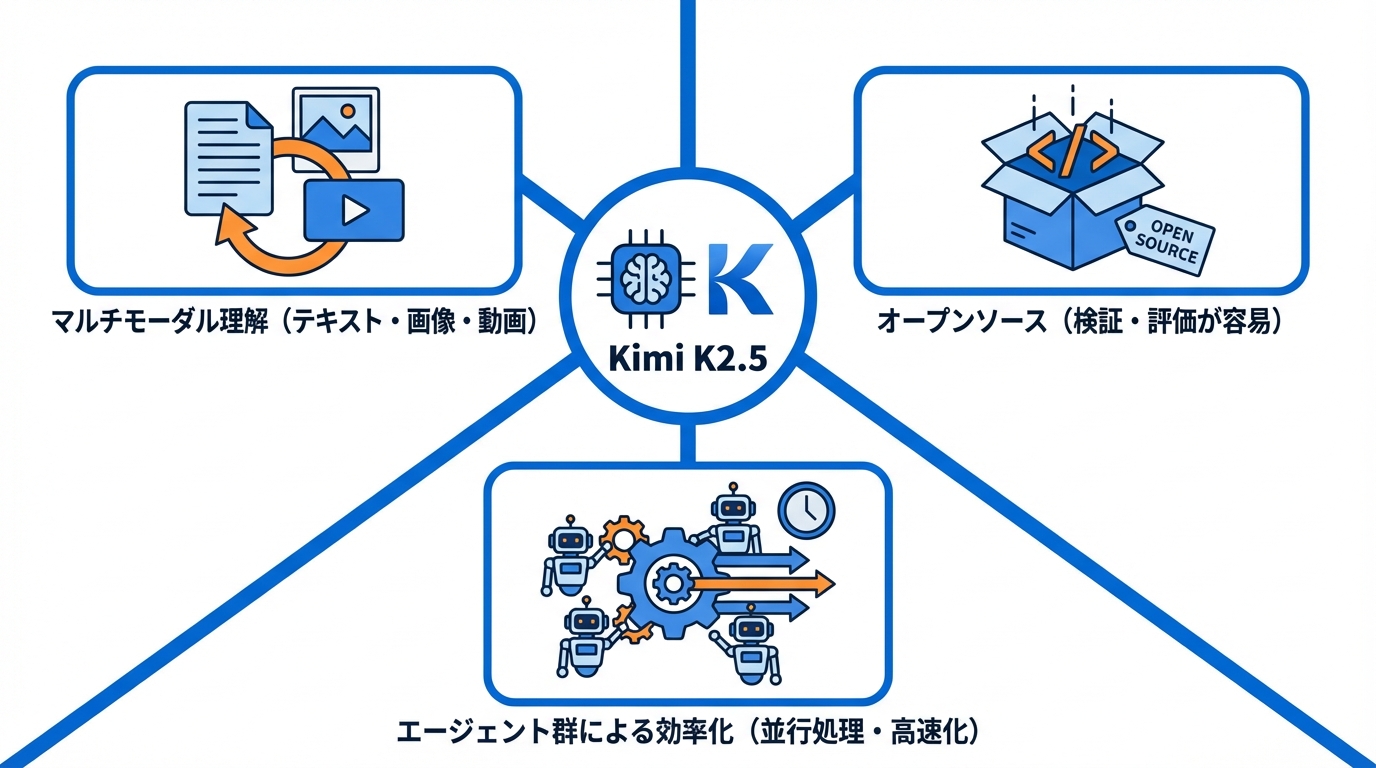

ここで押さえたいのは、Kimi K2.5が文章専用のモデルではなく、最初から画像や動画も扱う前提で作られている点です。たとえば画面のスクリーンショットを見ながら操作手順を作ったり、短い動画の内容を要約してナレッジ化したりといった使い方につながります(参照*1)。

また、Kimi K2.5は「オープンソース」として公開されています。これは一般に、社内検証や外部の開発者による評価を進めやすい形で提供される、という意味合いで使われます。実際の利用条件はライセンスで決まるため、後半で条件を具体的に確認します。

Kimi K2.5の主要特徴

Kimi公式ブログは、Kimi K2.5をKimi K2を土台にしつつ、視覚情報とテキスト情報を混ぜた約15T(15兆)トークンで継続的に事前学習した「ネイティブマルチモーダル」モデルだと整理しています(参照*2)。トークンは文章を細かく区切った単位だと考えると理解しやすく、15兆という規模は学習量の大きさを示す数字です。

同じくKimi公式ブログは、複雑な作業では最大100のサブエージェントで「エージェント群(Agent Swarm)」を自分で組み、最大1,500回の道具の呼び出しを並行して進め、実行時間を最大4.5倍短縮できると説明しています(参照*2)。ここでのエージェントは、目的に向けて手順を組み立てて作業する役割、と捉えると読みやすいです。

この特徴は、たとえば次のような作業で効いてきます。

- 大量のファイルを読み、必要な箇所を探して整理する

- 調べ物をしながら、途中結果をまとめて次の手順を決める

- 複数の道具を使う作業を、同時進行で進める

ただし、ここまでの説明は「できること」の範囲です。実務での期待値を決めるには、仕様(どんな設計か)と、評価(どのテストでどの結果か)を分けて見ると判断しやすくなります。

技術仕様:アーキテクチャと学習データ

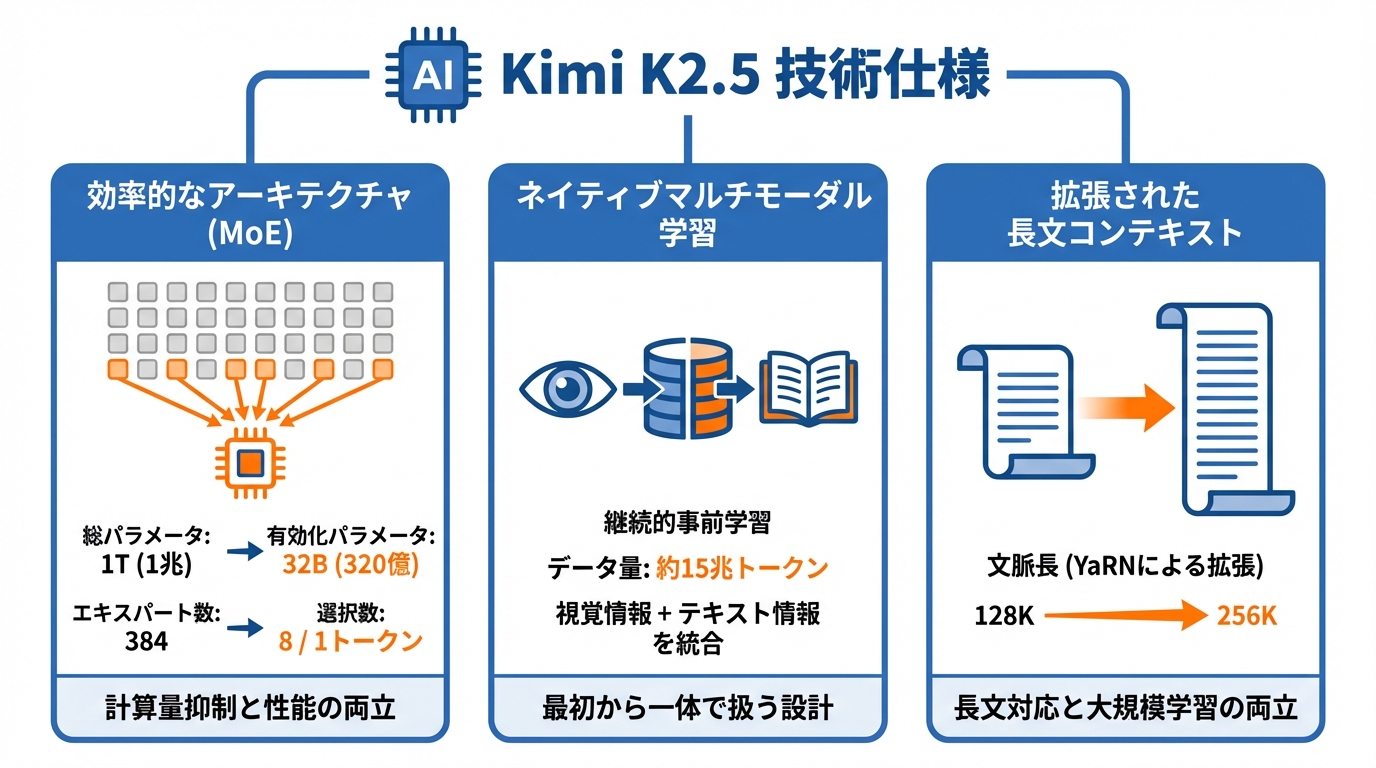

MoEアーキテクチャと規模

Kimi K2.5のモデル概要として、Hugging FaceのREADMEはアーキテクチャをMoE(Mixture-of-Experts、複数の専門家を使い分ける仕組み)だと示しています(参照*3)。入力に応じて一部を選んで動かす発想なので、規模が大きくても計算量を抑えやすい設計です。

同READMEによると、総パラメータは1T(1兆)で、実際に動く有効化パラメータは32B(320億)です(参照*3)。パラメータはモデルの「覚え方」の量に近いイメージで、総量と実動量が分かれている点が特徴です。

さらに同READMEは、エキスパート(専門家)の数が384で、1トークンあたり8つのエキスパートを選ぶと記載しています(参照*3)。この「選んで使う」設計が、性能と実用性の両立に関わるポイントになります。

学習データとネイティブマルチモーダル

Kimi K2.5の学習について、Hugging Faceのモデルページは、Kimi-K2-Baseの上に約15兆トークン分の視覚情報とテキスト情報を混ぜた継続的事前学習で作ったと説明しています(参照*4)。継続的事前学習は、土台モデルを作ったあとに、追加の大規模学習で能力を積み上げるやり方です。

同ページは、Kimi K2.5を「ネイティブマルチモーダル・エージェント型モデル」と表現し、視覚と言語理解を統合すると述べています(参照*4)。後から画像機能を付け足したのではなく、最初から画像と言葉を一体で扱う前提で設計している、という意味合いです。

また同ページは、瞬時・思考モード、会話モード、エージェント的な使い方を実現すると整理しています(参照*4)。言い換えると、短く即答する場面と、手順を踏んで考える場面、会話としてやり取りする場面、道具を使って作業する場面を、同じモデルでカバーする設計です。

長文コンテキストと推論効率

長い文章をどれだけ一度に扱えるかは、仕様書、議事録、規程集、複数ファイルのコードなどをまとめて扱う場面で差が出やすい要素です。news.smol.aiは、Kimi K2.5の文脈長(コンテキスト長)がYaRNにより128Kから256Kへ拡張されたと説明しています(参照*5)。コンテキスト長は、会話や資料をどれだけまとめて渡せるかの上限だと捉えると理解しやすいです。

同記事は、Kimi K2.5を32Bアクティブ-1Tパラメータのモデルとして紹介し、15兆の視覚・テキスト混合トークンでの継続的事前学習を特徴として挙げています(参照*5)。長文対応と大規模学習を同時に進めている点が、仕様としての骨格です。

一方で、長文を渡せることと、常に正しく理解できることは別です。長い資料ほど、誤読や見落としが混ざる可能性もあるため、実運用では「要約→確認→必要箇所だけ深掘り」の流れにすると運用しやすくなります。次は、数値で比較されるベンチマーク結果をどう読めばよいかを確認します。

性能検証:ベンチマーク結果の読み解き

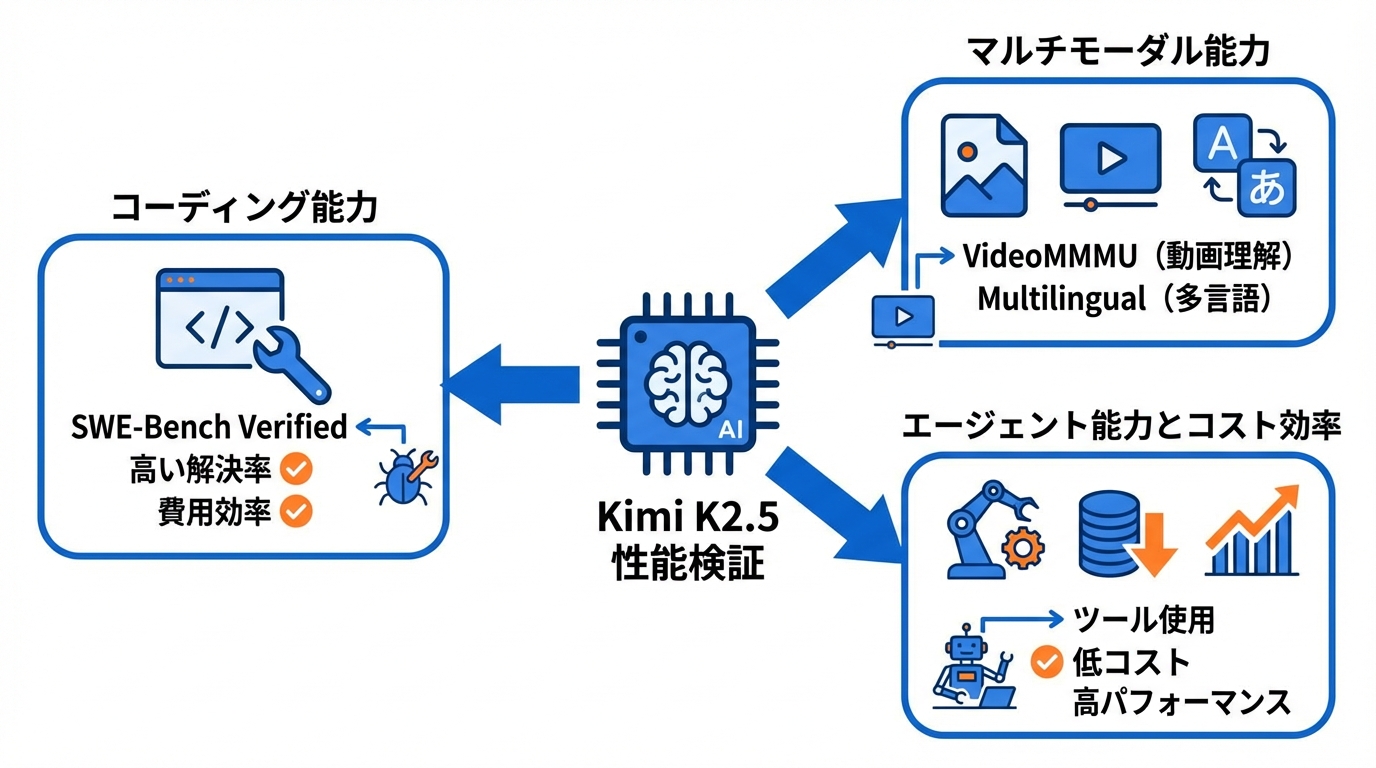

コーディングベンチマークの結果

コーディング性能は、修正作業、テスト作成、社内ツールの自動化などに直結しやすい指標です。WinBuzzerは、Constellation Researchの分析として、SWE-Bench VerifiedでKimi K2.5が80.9%の解決率を達成したと伝えています(参照*6)。

同記事は、HLE、BrowseComp、SWE-Verifiedといったテストで競争力がありつつ、最先端の非公開モデルと比べて費用効率を保つ、という文脈で整理しています(参照*6)。ここでの費用効率は、同程度の結果を得るのに必要なコストの話として読むと誤解が減ります。

SWE-Bench Verifiedは、実在のリポジトリを対象に、バグ修正のような課題で「テストが通る修正を出せたか」を見る枠組みとして知られています。数字を見るときは、どの条件(ツールあり/なし、試行回数など)で測った結果かを、元の発表や表と合わせて確認すると判断しやすくなります。

画像・動画ベンチマークの結果

マルチモーダル対応をうたうなら、画像や動画の評価が欠かせません。TechCrunchは、Kimi K2.5がビデオ理解のVideoMMMUでGPT 5.2やClaude Opus 4.5を上回ったと紹介しています(参照*1)。動画理解という別ジャンルのテストで比較が出ている点が読みどころです。

同じくTechCrunchは、コーディングのベンチマークでも、SWE-Bench VerifiedでGemini 3 Proを上回り、SWE-Bench MultilingualではGPT 5.2やGemini 3 Proを上回る得点を記録したと述べています(参照*1)。Multilingualは多言語条件の意味合いで、英語以外の情報が混ざる場面を含む、と捉えると読みやすいです。

業務に置き換えると、画面キャプチャの読み取り、図表の説明、短い動画の要点抽出、UIデザインからのコード生成などが近い領域です。TechCrunchは、画像や動画を入力として与え、同様のインターフェースを作成できると説明しています(参照*1)。実務では、入力データの権利や持ち出し可否も論点になるため、社内ルールと合わせて扱う必要があります。

エージェント指向ベンチマークとコスト観点

Kimi K2.5は、道具を使って作業を進める「エージェント」的な使い方も前提にしています。Constellation Researchは、リリースノートでOpenAIのChatGPT 5.2と比較し、HLE、BrowseComp、SWE-Verifiedという3つのエージェント指向ベンチマークで、費用のごく一部で高いパフォーマンスを示すと述べたと整理しています(参照*7)。

エージェント型は、検索、ファイル操作、実行確認などで道具の呼び出し回数が増えやすく、料金や待ち時間に跳ね返ります。だからこそ「費用のごく一部」という表現が、評価の軸として出てきます(参照*7)。

また、エージェント系の評価は、課題の作り方で結果が動きやすい面もあります。数字だけで即決せず、社内でよくある作業(社内問い合わせの一次回答、規程の検索、定型レポート作成、改修チケットの下書き)を小さく再現し、時間とコストとミス率を見てから広げると、PoC止まりを避けやすくなります。次は、実際に使うためのライセンス、提供形態、導入手順を具体的に見ていきます。

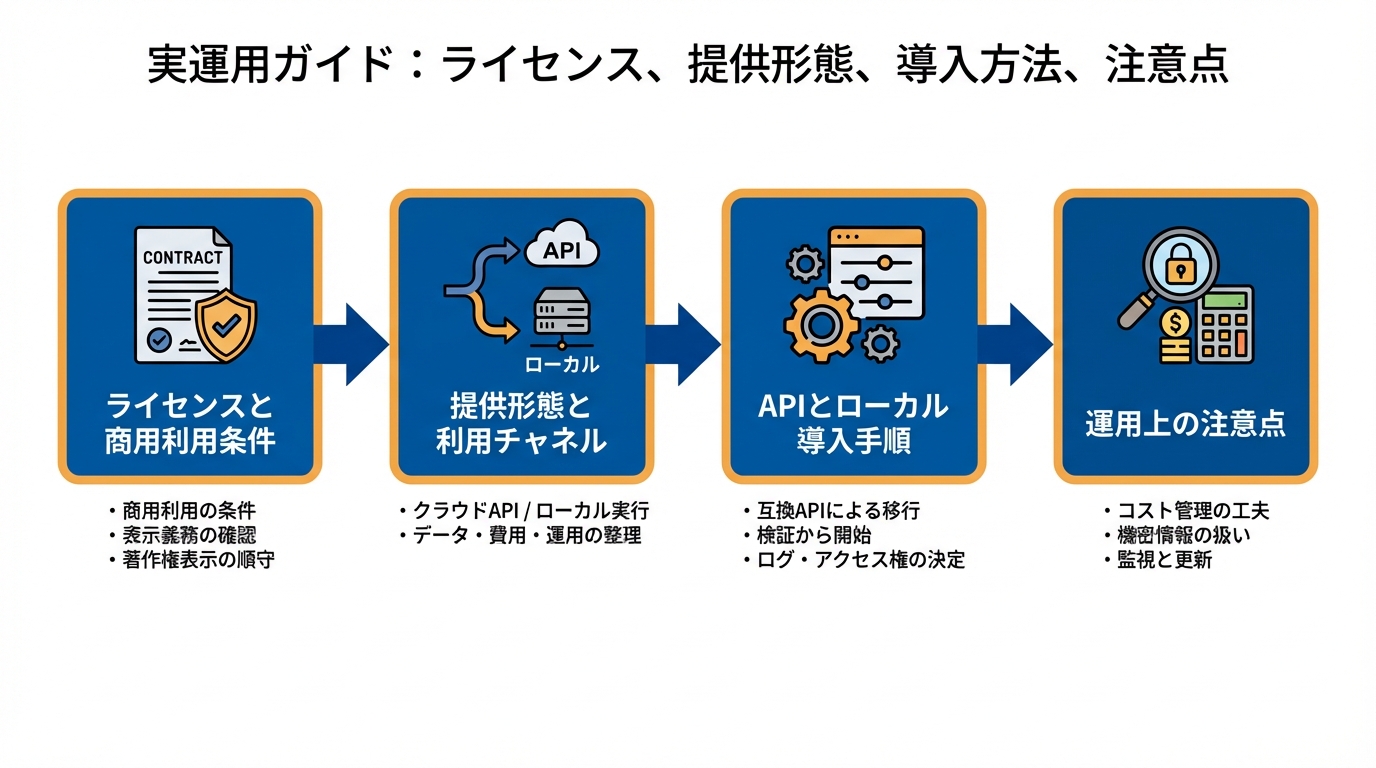

実運用ガイド:ライセンス、提供形態、導入方法、注意点

ライセンスと商用利用条件

オープンソースでも、商用利用の条件は必ず確認が必要です。Modified MIT Licenseの要約では、商用製品・サービスにおいて、月間アクティブユーザーが1億を超える場合、または月間収益が2000万USドルを超える場合には、同社はその旨を目立つ場所に表示する必要がある、と記載されています(参照*8)。

月間アクティブユーザーは、1か月の間に実際に使った人の数です。月間収益は、1か月の売上に近い意味合いで使われます。条件に当てはまる規模の事業では、表示対応が運用に入ってくるため、法務や広報の確認事項になります。

一方で、条件に当てはまらない規模でも、著作権表示などライセンス本文の順守は必要です(参照*8)。利用形態が、モデルそのものの配布なのか、社内利用なのか、外部向けサービス提供なのかで論点が変わるため、導入前に「誰が、どのデータで、どこで使うか」を文章で整理しておくと確認が進みやすくなります。

提供形態と利用チャネル

Kimi K2.5は、クラウド経由のAPIと、モデル配布によるローカル実行の両方が想定されています。Hugging FaceのREADMEは、Kimi-K2.5のAPIをhttps://platform.moonshot.ai で提供し、OpenAI/Anthropic互換のAPIを用意すると説明しています(参照*3)。互換APIは、呼び出し方を似せて移行しやすくする考え方だと捉えるとよいです。

同READMEは、推論エンジンとしてvLLM、SGLang、KTransformersを推奨し、transformersの最小バージョンを4.57.1と示しています(参照*3)。推論は、学習済みモデルを使って答えを出す処理のことです。

利用チャネルを選ぶときは、社内データを外に出せるか、待ち時間と費用をどう見積もるか、運用担当がどこまで面倒を見られるかを先に整理すると迷いにくいです。APIは始めやすく、ローカルは環境づくりが必要な代わりに制御しやすい、という違いが出ます。

APIとローカル導入手順

API利用では、互換APIの存在が移行コストに効きます。Apidogは、Kimi K2.5がOpenAI互換APIへのドロップイン置換に対応し、100万トークンあたり$0.60の価格設定、256Kのコンテキストウィンドウを特徴とすると紹介しています(参照*9)。ドロップイン置換は、呼び出し部分を大きく変えずに差し替える、という意味合いです。

価格の見方としては、入力と出力でトークンが増えるほど費用が増えます。256Kの長文を扱える設計は便利ですが、長文をそのまま投げ続けるとコストも増えやすくなります。運用では、①先に要約してから質問する、②必要部分だけを切り出す、③同じ資料はベクトル検索などで参照する、といった工夫が現実的です(一般的な説明)。

ローカル導入では、まず目的を決めるのが近道です。検証だけなら小さく始め、社内システムに組み込むなら監視や更新まで含めて考えます。さらに、入力に個人情報や機密が含まれる場合は、ログの保存範囲、アクセス権、監査の取り方を先に決めておくと、社内説明が通りやすくなります(一般的な説明)。

Kimi Codeと運用上の注意点

Kimi Codeは、開発作業を進めるためのCLI(コマンドラインツール、文字で命令を打つ道具)として案内されています。Moonshot AIのガイドは、Kimi Code CLIが現在技術プレビュー段階で、機能やAPIが変更される可能性があると注意書きしています(参照*10)。

同ガイドは、Linux/macOSでは「curl -LsSf https://code.kimi.com/install.sh | bash」、WindowsではPowerShellでのインストール例を示し、インストール確認として「sh kimi –version」を挙げています(参照*10)。手順が短い分、社内の端末管理ルールに合うか、スクリプト実行を許可できるか、といった確認が必要になります。

運用上は、道具を使うAIほど「何をしたか」を追える形にするのがポイントです。技術プレビュー段階では仕様変更も起き得るため、業務の中核にいきなり組み込むより、まずは検証環境でログの取り方、失敗時の戻し方、権限の与え方を固めると進めやすくなります。ファイル操作や外部送信が絡む場合は、対象フォルダを限定する、実行前に差分を出す、最後は人が承認する、といった手順にすると事故を減らせます(一般的な説明)。

おわりに

Kimi K2.5は、Moonshot AIが2026年1月に公開した、テキスト・画像・動画を扱うネイティブマルチモーダルのオープンソースモデルとして整理できます(参照*1)。MoE構造(総1T/有効化32B)、約15Tトークンの学習、256Kの長文対応、そして最大100サブエージェントのAgent Swarmが、仕様と使い方の軸になります(参照*4)(参照*2)。

導入判断では、ベンチマークの強さだけでなく、ライセンス条件、APIの価格、ローカル実行の前提、技術プレビューの道具の扱いまで含めて確認が必要です(参照*8)(参照*9)。社内でよくある作業を小さく再現して、工数、コスト、ミスの出方を見ながら広げると、PoC止まりを避けやすくなります。

監修者

安達裕哉(あだち ゆうや)

デロイト トーマツ コンサルティングにて品質マネジメント、人事などの分野でコンサルティングに従事しその後、監査法人トーマツの中小企業向けコンサルティング部門の立ち上げに参画。大阪支社長、東京支社長を歴任したのち2013年5月にwebマーケティング、コンテンツ制作を行う「ティネクト株式会社」を設立。ビジネスメディア「Books&Apps」を運営。

2023年7月に生成AIコンサルティング、およびAIメディア運営を行う「ワークワンダース株式会社」を設立。ICJ2号ファンドによる調達を実施(1.3億円)。

著書「頭のいい人が話す前に考えていること」 が、82万部(2025年3月時点)を売り上げる。

(“2023年・2024年上半期に日本で一番売れたビジネス書”(トーハン調べ/日販調べ))

参照

- (*1) TechCrunch – China’s Moonshot releases a new open source model Kimi K2.5 and a coding agent

- (*2) Kimi K2.5: Visual Agentic Intelligence

- (*3) README.md · moonshotai/Kimi-K2.5 at main

- (*4) moonshotai/Kimi-K2.5 · Hugging Face

- (*5) AI News – Moonshot Kimi K2.5 – Beats Sonnet 4.5 at half the cost, SOTA Open Model, first Native Image+Video, 100 parallel Agent Swarm manager

- (*6) Moonshot AI Unveils Kimi K2.5 Open-Source Model, Claiming to Beat Claude Opus 4.5 on Agentic Benchmarks

- (*7) Moonshot's Kimi K2.5 introduces agent swarm, highlights open source model momentum

- (*8) Update LICENSE · moonshotai/Kimi-K2-Thinking at 357b94a

- (*9) Kimi K2.5 API の使い方

- (*10) Kimi Code CLI Docs