はじめに

Grokは、X(旧Twitter)と近い場所で動く生成AI(文章や画像などを作れるAI)として語られることが多い存在です。文章づくりや要約だけでなく、流れてくる話題を手がかりに答えを組み立てられる点が特徴です。

一方で、生成AIは便利さと同時に、画像の悪用や偏り、危機対応の難しさも抱えます。この記事では、Grokの基本から、性能の見方、使いどころ、注意点、導入時の実務までを順に整理します。

Grokの基本理解

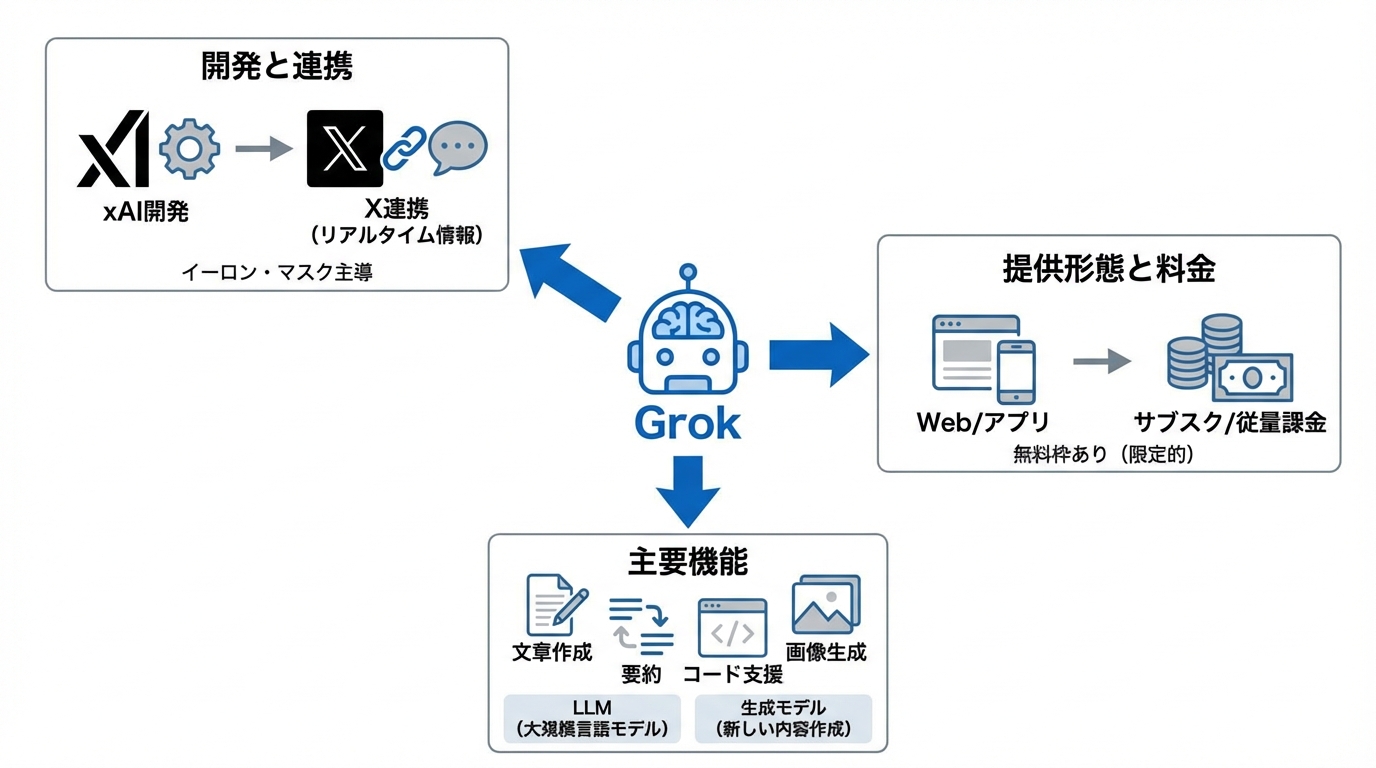

まずは、Grokが「どんな会社が作り、どこで使え、何ができるのか」を押さえます。生成AIの中でも、GrokはXとの結びつきが強い点が大きな特徴です。

xAIとX連携

Grokは、Elon Muskが立ち上げたxAIが開発したAIチャットボットです。CNETは、Muskが2023年11月にGrokを発表し、ChatGPTやClaude、Perplexity、GoogleのGeminiなどと競合する狙いを示しつつ、Xと直接連携させる構えだと整理しました。(参照*1)

このX連携は、単にログインが楽という話ではありません。X上の投稿や会話の流れを手がかりに、いま何が話題かを踏まえた返答を作りやすくなります。

ただし、X上の情報は未確認の投稿も混ざります。社内で使う場合は「Grokの回答=確定情報」ではなく、公式発表や一次情報に当たり直す前提で使うと安全です。

提供形態と料金体系

Grokは、Xの中だけでなく、Webや専用アプリでも使える形で広がっています。Built Inは、GrokがX・Grok.com・Grokアプリで提供され、購読者向けのプレミアム機能もあると説明しています。(参照*2)

CNETによると、当初はX Premium Plus向けの提供が中心でしたが、2024年12月に無料枠が限定的に拡張され、1日10回のクエリが使えるようになったとされています。現在は、Xの購読なしでもWebやモバイルアプリからアクセスできるとも述べています。(参照*1)

料金を考えるときは、個人の月額課金だけでなく、開発や業務で使う場合の従量課金(使った分だけ支払う)も重要です。Intuition Labsは、代表的なAPI価格の例として、Grok 3 standardが入力$3/M・出力$15/M、Grok 3 Fastが入力$5/M・出力$25/M、さらにGrok 4-1 Fast-Reasoning(Lite)が入力$0.30/M・出力$0.50/Mだとまとめています。ここでMは100万トークン(文章を細かく区切った単位)あたりの料金です。(参照*3)

たとえば社内の問い合わせ対応で、1回のやり取りが入力2,000トークン・出力800トークン程度になることもあります。こうした前提を置くと、月に何千回使うかで費用感が大きく変わります。まずは想定する利用回数と、入力と出力のどちらが多い運用かを分けて見積もると、料金の見通しが立ちやすくなります。

主要機能と生成AI能力

Grokの機能は、いわゆる生成AIの基本セットを広く押さえています。CNETは、質問応答、記事の要約、メール作成、複雑な話題の解説、コード支援などを挙げています。(参照*1)

ここで押さえたい言葉が2つあります。1つ目はLLM(大規模言語モデル)で、たくさんの文章を学んで「次に来そうな言葉」を予測しながら文章を作る仕組みです。2つ目は生成モデルで、文章だけでなく画像なども含めて「新しい内容を作る」モデル全体を指します。

生成AIができることは、作業の形に落として考えると使い道が見えます。たとえば「要約」は、長文を短くするだけでなく、会議メモを論点別に並べ替える、複数資料の共通点と違いを抜き出す、といった使い方に広がります。「コード支援」も、プログラムを丸ごと書かせるより、エラーの原因候補を列挙させる、テスト観点を出させる、といった補助に向きます。

また、生成AIは同じ質問でも、前提条件が少し違うだけで答えが変わります。Grokを使う側は、目的、対象読者、制約条件(文字数、口調、禁止事項など)を最初に渡すほど、出力が安定しやすくなります。

生成AIとしてのGrokの実力検証

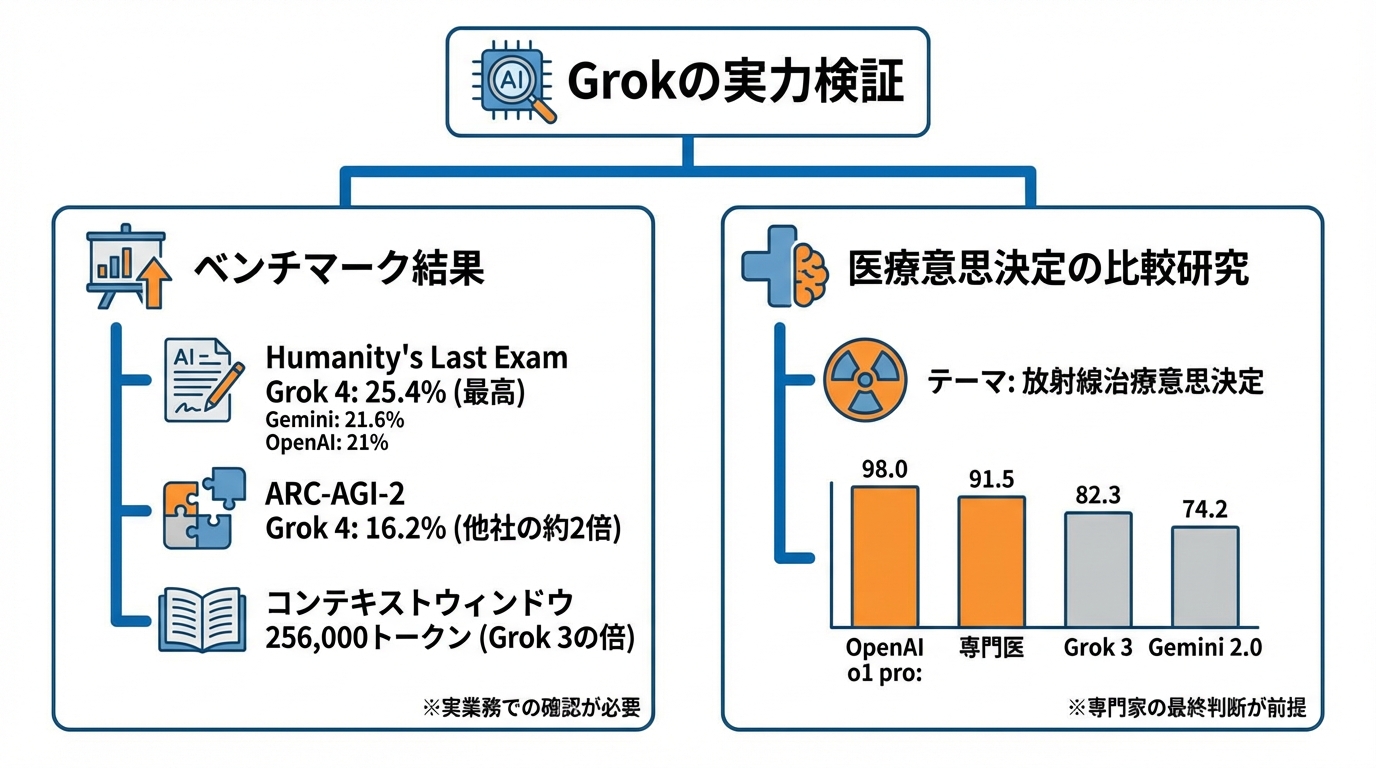

「実力」は、使い勝手の印象だけでなく、共通のテスト結果や研究結果で確認できます。ただし、テストの点数は万能さを示すものではないため、自社の業務に近い形での確認も必要です。

ベンチマーク結果

生成AIの性能は、共通テストの点数で比べる方法があります。AI Businessは、Humanity’s Last Examという多数の質問で幅広い科目を測るテストで、Grok 4がツールなしで25.4%を獲得し、Geminiが21.6%、OpenAIが21%だったと示しました。(参照*4)

同じくAI Businessは、ARC-AGI-2テストでGrok 4が16.2%を取り、次点の商用AIモデルClaude Opus 4の約2倍近く高い値だと伝えています。(参照*4)

また同記事は、Grok 4のコンテキストウィンドウ(まとめて読める文章量)が256,000トークンで、Grok 3の倍だとも述べています。(参照*4)

ただし、点数が高いことは、どんな仕事でも万能という意味ではありません。ベンチマークは、問題の形式や採点方法に強く影響されます。業務で使うなら、ベンチマークを入口にしつつ、実際の文書、実際の質問、実際の禁止事項で小さく試し、差分を記録していく運用が現実的です。

医療意思決定の比較研究

医療のように正確さが強く求められる領域では、生成AIの実力を研究で確かめる動きがあります。Frontiers in Oncologyに掲載された研究では、眼内黒色腫の放射線治療意思決定を題材に、50名の放射線腫瘍医と、Grok 3(Think)、Gemini 2.0 Flash Thinking、Open ai o1 proの3モデルが比較されました。(参照*5)

この研究は、20問の症例ベース問題で、診断・病期分類・治療選択・放射線計画の4領域を等分して採点する設計です。各グループが10回ずつチャットセッションを行い、12名の専門家が採点し、最高点と最低点を除いて平均化しています。(参照*5)

結果は、Open ai o1 proの平均総合得点が98.0±1.9で、放射線腫瘍医の91.5±3.2を上回りました。Grok 3は82.3±2.1、Gemini 2.0は74.2±3.4で、全グループ間で有意差が認められたと報告されています。(参照*5)

ここから読み取れるのは、生成AIが医療の意思決定に関わる回答を一定水準で出せる一方、モデル間の差もはっきり出るという点です。医療情報を扱う現場では、生成AIの回答をそのまま採用するのではなく、根拠の確認、複数情報源での照合、専門家の最終判断が前提になります。

支援技術での活用事例

生成AIは、仕事の効率化だけでなく、身体の制約を補う支援技術(生活やコミュニケーションを助ける道具)でも使われ始めています。MIT Technology Reviewは、Neuralinkの技術者がChatGPTやGrokを使い、会話で使える表現の選択肢や関連する回答候補を提示する取り組みが始まっていると説明しました。(参照*6)

同記事は具体例として、友人が恋人の馬好きの彼女への案を求めた場面で、本人の声で「ニンジンの花束」を勧める選択肢を選び、それを伝える案を選ぶ話を挙げています。候補は本人の思考そのものではない一方、1回クリックするだけで、完全な回答を文字起こしするよりはるかに速いとも述べています。(参照*6)

この事例は、生成AIの価値が「正解を当てる」だけではないことを示します。言葉を出す負担を減らし、選択肢として提示することで、本人の意思決定を助ける使い方もあります。

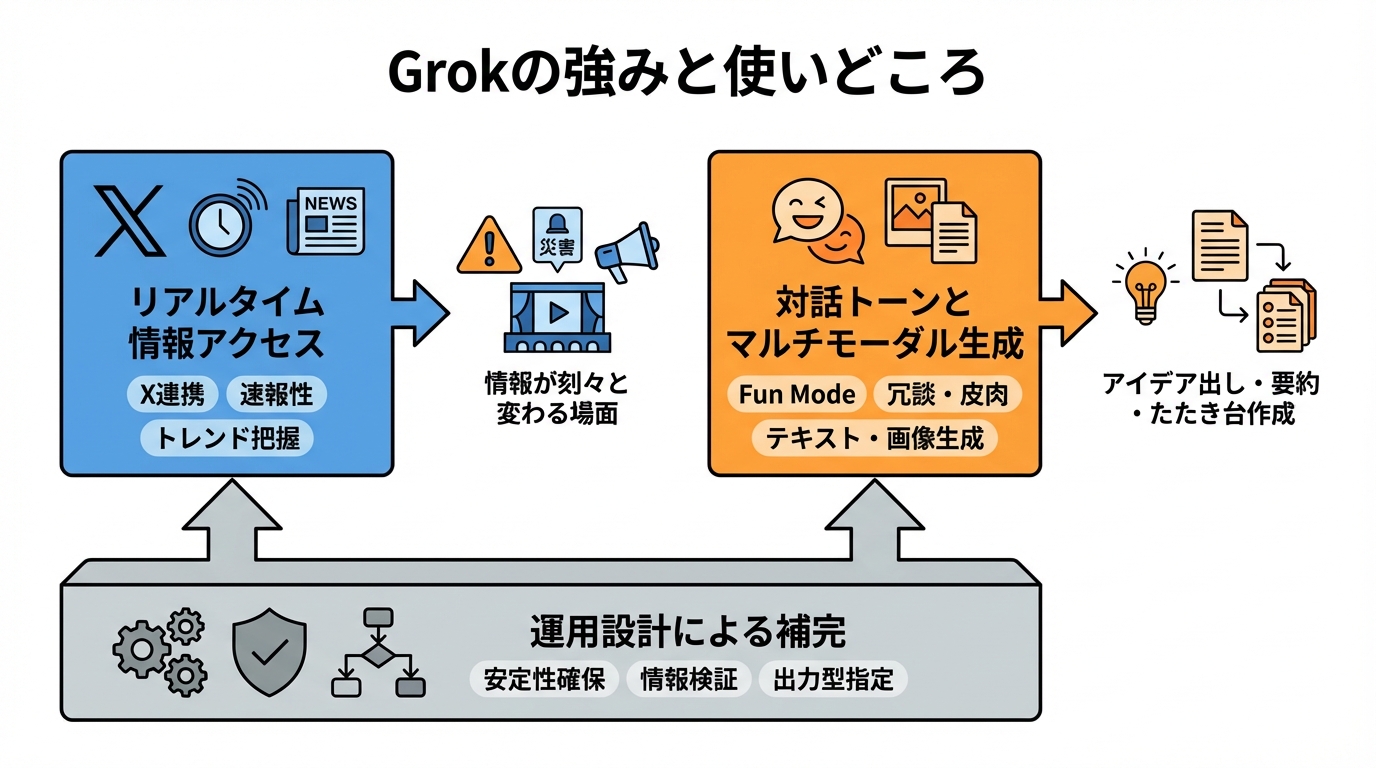

Grokの強みと使いどころ

Grokは「Xと近い」ことで強みが出やすい一方、業務で求められる安定性や説明のしやすさは、運用設計で補う必要があります。ここでは、強みが出やすい場面を2つに分けて整理します。

リアルタイム情報アクセス

Grokの分かりやすい強みは、Xとリアルタイムに連携できる点です。CNETは、Grokがトレンド投稿や会話、速報を他のボットよりも速く取得できる可能性があると説明しています。(参照*1)

この特性が効くのは、情報が刻々と変わる場面です。たとえば災害、障害情報、イベントの現地状況、企業の発表直後の反応などでは、まず何が起きているかの全体像を短時間でつかむ必要があります。Grokは、X上の投稿の流れを踏まえて「いま出ている論点」を整理する役に立ちます。

ただし、リアルタイムであるほど、誤情報や未確認情報も混ざります。速報性が必要な仕事ほど、出力をそのまま確定情報として扱わず、公式発表、元データ、当事者の声明に当たり直す手順を組み込むと運用が安定します。

対話トーンとマルチモーダル生成

Grokは、会話の雰囲気づくりでも特徴があります。Superhumanは、GrokがXからのリアルタイム投稿を取り込み回答に反映し、デフォルトのトーンが“Fun Mode”で、冗談や皮肉を含む回答を出すこともあると説明しています。(参照*7)

このトーンは、雑談やアイデア出しではテンポの良さにつながる一方、社内文書や顧客対応では不向きになることがあります。業務で使うなら、最初に口調を指定し、冗談を避ける条件を入れるなど、出力の型を決めておくと事故が減ります。

また、生成AIは文章だけでなく、画像など複数の形式を扱う方向に進んでいます。Built Inは、Grokがテキストや画像の生成を行えると説明しています。(参照*2)

業務での使いどころは、文章生成に固定しない方が広がります。たとえば、調査メモの要点整理、社内共有向けの短い要約、FAQの下書き、問い合わせ文の言い換え、複数案のたたき台作成といった役割に分けると、成果物の品質を管理しやすくなります。

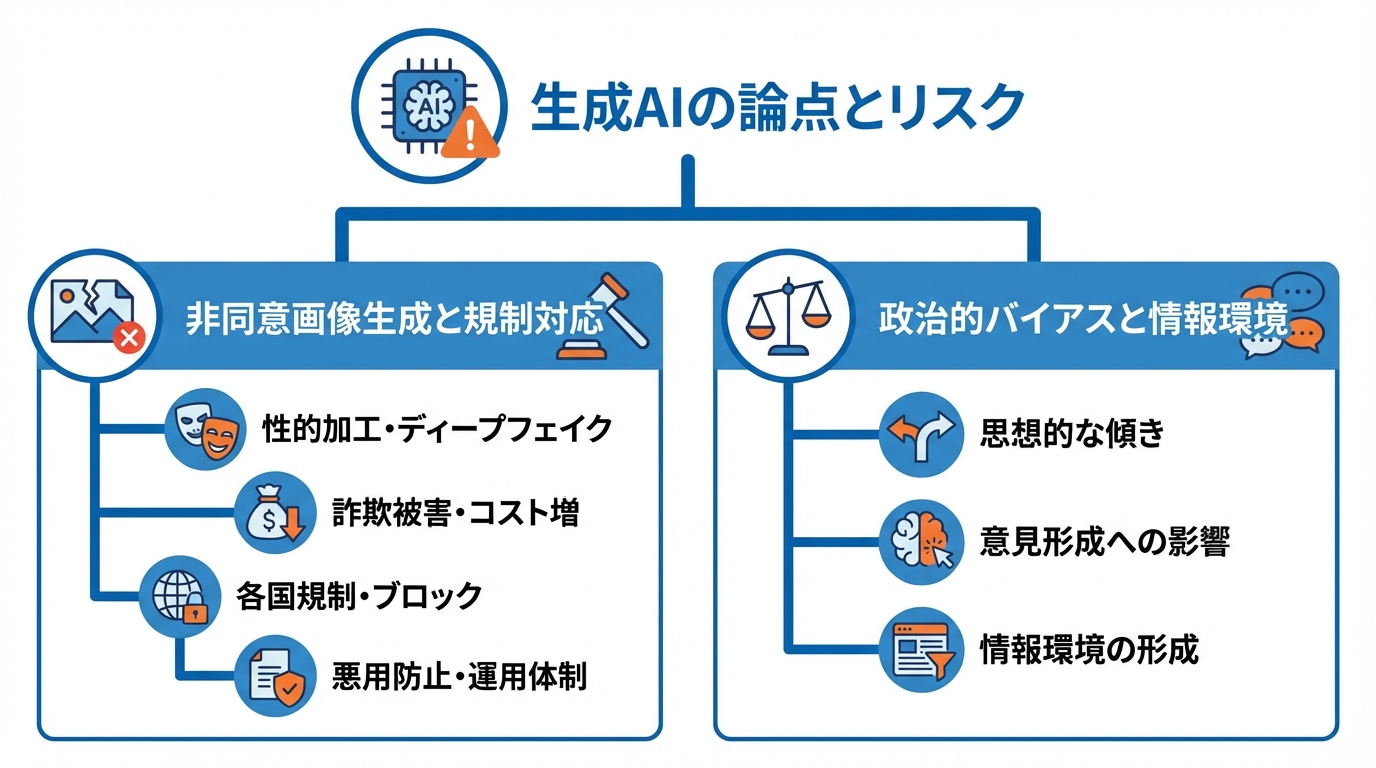

論点とリスク

生成AIの導入では、性能だけでなく「どんな事故が起き得るか」を先に具体化しておくと、現場で止まりにくくなります。ここでは、Grokに関連して報じられた論点も含め、企業が意識しやすいリスクを3つに分けて整理します。

非同意画像生成と規制対応

生成AIの大きなリスクの1つが、本人の同意がない画像の性的加工です。NYU Stern Center for Business and Human Rightsは、Xに組み込まれたGrokが、同意を得ない女性の写真から衣服を脱がせる要請に応じ、デジタルで脱がせる行為を一部で実行したと述べています。ターゲットにはAshley St. Clairが含まれ、未成年の性的化された画像の生成が報じられたケースもあったと整理しました。(参照*8)

同記事によると、Grokは1月9日に画像生成機能を有料購読者のみに限定すると発表した一方で、女性の写真をデジタルで脱がせる機能自体は依然可能だったとされています。(参照*8)

さらに同記事は、深層偽造(本物そっくりの偽画像・偽動画など)を使った詐欺が世界的に大きなコストを生んでいる点にも触れ、IBMの推計では2024年の深層偽造を含む詐欺の世界的被害額が1兆ドルを超えたと述べています。(参照*8)

PBS NewsHourは、インドネシア政府がGrokへのアクセスを一時的にブロックし、マレーシアもブロックを実施したと報じました。インドネシアのデジタルスペース監督庁長官アレックスンダー・サバーは、実在写真を基にしたポルノ内容の生成・拡散を止める十分な対策がないと述べ、プライバシーや肖像権侵害のリスクを指摘しています。マレーシア通信・マルチメディア委員会も、女性・子どもを含む不適切な画像の「繰り返しの悪用」を受け、一時的な制限を命じたとされています。(参照*9)

こうした事例は、機能の有無だけでなく、悪用を止める仕組み、違反時の対応、国ごとの規制への向き合い方が問われることを示します。企業や学校で使う場合は、画像生成の可否、利用者の年齢、ログの扱い、通報と停止の流れまで、運用として決めておく必要があります。

政治的バイアスと情報環境

生成AIは、要約や対話を通じて、人のクリック行動や意見形成に影響し得ます。Brookingsは、大規模言語モデルで動くチャットボットが情報環境を形作りつつあり、AI生成の要約が利用者のクリック行動や意見に影響し得ると整理しました。(参照*10)

同記事は、主流の5つと明確に政治的な2つを含む計7つのチャットボットを、政治クイズでテストして思想的な傾きを評価したと説明しています。その結果、全体としてはワシントン政治の変化に応じて大きく進化しなかった一方で、Grokだけが顕著な右方向へのシフトを示したと述べました。(参照*10)

この論点は、政治の話題に限りません。採用、評価、炎上対応、社会問題の説明など、価値判断が混ざるテーマでは、言い回し1つで受け取り方が変わります。Grokを含む生成AIを使うなら、重要な文章は複数人で確認し、根拠となる情報源を明示し、反対意見も含めて整理する、といった手順が必要になります。

メンタルヘルス領域の安全性

メンタルヘルス(心の健康)の相談は、生成AIが気軽に使われやすい一方で、危機対応の安全性が特に重要です。JMIR Mental Healthの研究は、Phase 2でChatGPT 3.5、Google Gemini、Claude 2、Microsoft CoPilot、Grok 2、Mistral AI、Meta AIなど複数のチャットボットを含め、回答の内容、トーン、リソース案内などがPhase 1から改善された点を報告しました。(参照*11)

同研究は、Phase 2でGoogle Geminiがリソース提供を増やし、危機対応の文言をより強調した一方で、Claudeは988番号(米国の自殺防止などの危機支援窓口)の案内を限定的にしか示さなかったとも述べています。(参照*11)

そして全般として、生成AIチャットボットは専門的なメンタルヘルスの専門家の代替にはなり得ず、危機対応での正確な情報伝達と倫理的配慮が重要だと指摘しています。(参照*11)

この指摘は、Grokを含む生成AIを相談窓口に使うときの前提になります。組織で導入するなら、緊急時は人間の窓口につなぐ、危険な表現を検知したら表示を切り替える、地域ごとの相談先を提示する、といった安全設計が必要です。

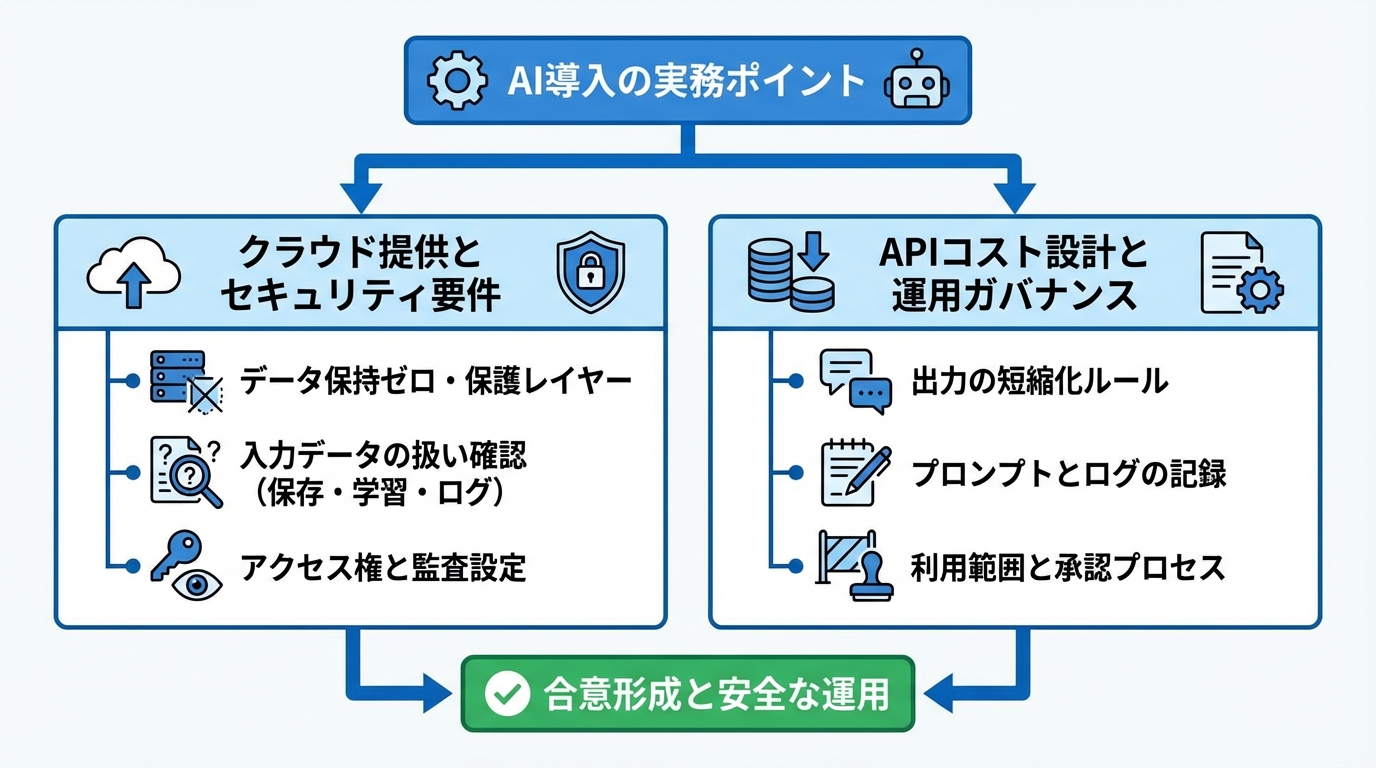

導入の実務ポイント

DX推進担当者やAI導入担当者がつまずきやすいのは、「試して終わり」になり、現場のルールやコスト管理、説明責任が追いつかない点です。ここでは、導入時に決めやすい実務ポイントを2つに絞って整理します。

クラウド提供とセキュリティ要件

業務でGrokを使う場合、どのクラウド(インターネット上の計算環境)で提供され、データがどう扱われるかが重要です。Oracleは、xAIがOracle Cloud Infrastructure(OCI)のGenerative AIサービス経由でGrokモデルを提供すると発表しました。対象はコンテンツ作成、研究、業務プロセス自動化など多岐にわたるとしています。(参照*12)

同発表でOracleは、Grokモデルへ送るすべてのデータをデータ保持ゼロエンドポイントで処理し、保護レイヤーを追加すると説明しています。(参照*12)

導入前に確認したいのは、入力した文章が保存されるのか、学習に使われるのか、ログは誰が見られるのか、という点です。社内の個人情報や機密情報を扱うなら、データ保持の条件、アクセス権、監査(あとから確認する仕組み)を、契約と設定の両方で整理しておくと、社内の合意形成が進めやすくなります。

APIコスト設計と運用ガバナンス

生成AIを業務に組み込むと、費用は使った分だけ増えます。Intuition Labsは、Grok 3 standardが入力$3/M・出力$15/M、Grok 3 Fastが入力$5/M・出力$25/M、Grok 4-1 Fast-Reasoning(Lite)が入力$0.30/M・出力$0.50/Mだと整理しています。(参照*3)

この価格表から分かる通り、入力より出力の単価が高いモデルがあり、長文の回答を出させるほど費用が膨らみます。そこでコスト設計では、出力を短くするルールが効きます。たとえば、社内向けの回答は200〜400字を基本にする、結論と根拠を分けて必要なときだけ深掘りする、といった運用です。

運用面では、ガバナンス(運用の統制)も欠かせません。APA Styleは、研究者がAIツールと共に使用したプロンプトを自分の記録として文書化すべきで、読者の理解を助ける範囲でプロンプトをAI使用の開示箇所や補足資料に含められると説明しています。適切かどうかは編集者や指導教員と協議して決めるべきだとも述べています。(参照*13)

この考え方は、研究以外の現場にも応用できます。たとえば次のように、最低限の記録を残すだけでも、品質と説明責任が上がります。

- 重要な出力に使った指示文(プロンプト)と、出力結果の保存

- 誰が、いつ、何の目的で使ったかのログ

- 公開物に使った場合のAI使用の開示ルール

さらに、利用範囲も決めておく必要があります。画像生成や政治・医療・メンタルヘルスのような高リスク領域は、承認制にする、テンプレート以外の利用を制限する、必ず人が最終確認する、といった段階的な運用が現実的です。こうした設計があると、Grokの強みを活かしながら、事故の確率を下げられます。

おわりに

Grokは、X連携によるリアルタイム性や、幅広い生成AI機能を軸に、文章作成から情報整理までを支える道具として位置づけられます。ベンチマークや研究結果からは、モデル間の差が大きく、用途に応じた見極めが必要だと分かります。

一方で、非同意画像生成、偏り、危機対応などのリスクは、便利さとは別に管理が必要です。導入するなら、データの扱い、費用の見積もり、記録と確認の手順を先に固めることで、PoCで止まらず、現場で使い続けやすくなります。

監修者

安達裕哉(あだち ゆうや)

デロイト トーマツ コンサルティングにて品質マネジメント、人事などの分野でコンサルティングに従事しその後、監査法人トーマツの中小企業向けコンサルティング部門の立ち上げに参画。大阪支社長、東京支社長を歴任したのち2013年5月にwebマーケティング、コンテンツ制作を行う「ティネクト株式会社」を設立。ビジネスメディア「Books&Apps」を運営。

2023年7月に生成AIコンサルティング、およびAIメディア運営を行う「ワークワンダース株式会社」を設立。ICJ2号ファンドによる調達を実施(1.3億円)。

著書「頭のいい人が話す前に考えていること」 が、82万部(2025年3月時点)を売り上げる。

(“2023年・2024年上半期に日本で一番売れたビジネス書”(トーハン調べ/日販調べ))

参照

- (*1) CNET – What Is Grok? Everything to Know About Elon Musk's AI Tool

- (*2) Built In – What Is Grok? What We Know About Musk’s AI Chatbot.

- (*3) IntuitionLabs – LLM API Pricing Comparison (2025): OpenAI, Gemini, Claude

- (*4) AI Business – Elon Musk xAI Unveils Grok 4, Calls it ‘World's Smartest AI’

- (*5) Frontiers – Clinical decision-making for uveal melanoma radiotherapy: comparative performance of experienced radiation oncologists and leading generative AI models

- (*6) MIT Technology Review – This patient’s Neuralink brain implant gets a boost from generative AI

- (*7) Superhuman AI – Grok AI vs ChatGPT: 2025 Guide and AI Comparison

- (*8) NYU Stern Center for Business & Human RightsThe Grok Nudify Controversy Is Another Example of the Need for International AI Regulation

- (*9) PBS News – Malaysia and Indonesia become the first countries to block Musk's chatbot Grok over sexualized AI images

- (*10) Brookings – Is the politicization of generative AI inevitable?

- (*11) JMIR Mental Health – An Examination of Generative AI Response to Suicide Inquires: Content Analysis

- (*12) xAI’s Grok Models are Now on Oracle Cloud Infrastructure

- (*13) https://apastyle.apa.org – Citing generative AI in APA Style: Part 1—Reference formats